La physique quantique n’est plus une science étrange à subir, mais un domaine d’ingénierie à maîtriser pour innover.

- Les « bizarreries » comme la superposition et l’effet tunnel sont devenues des leviers de performance pour le calcul, les capteurs et les écrans.

- Le véritable défi de l’ingénieur n’est plus de comprendre le « pourquoi » philosophique, mais de maîtriser le « comment » technique : contrôler ces états quantiques fragiles.

Recommandation : Abordez les concepts quantiques non comme des paradoxes, mais comme les spécifications techniques de votre prochaine boîte à outils d’ingénierie.

Pour de nombreux ingénieurs, la physique quantique évoque des souvenirs de cours théoriques complexes, remplis d’équations intimidantes et de paradoxes déroutants comme le chat de Schrödinger. Une discipline fascinante, certes, mais réservée aux physiciens théoriciens dans leurs laboratoires, loin des contraintes de production, de rendement et de fiabilité. Cette vision, autrefois justifiée, est aujourd’hui obsolète. L’infiniment petit a envahi notre technologie, et ce qui était hier une curiosité intellectuelle est devenu une nécessité technique. Les transistors sont si petits que les électrons les traversent par effet tunnel, une « fuite » qui est en réalité un pur phénomène quantique. Les écrans les plus vifs de nos téléviseurs doivent leurs couleurs éclatantes à de minuscules « boîtes » à électrons appelées points quantiques.

Le changement de paradigme est radical : il ne s’agit plus de subir les effets quantiques, mais de les concevoir, de les contrôler et de les exploiter. La question n’est plus seulement « qu’est-ce que la superposition ? », mais « comment puis-je utiliser la superposition pour traiter une quantité d’information colossale en parallèle ? ». Ce n’est plus « pourquoi un électron traverse-t-il une barrière isolante ? », mais « comment puis-je construire un capteur d’une sensibilité inouïe basé sur ce principe ? ». La physique quantique est sortie du tableau noir pour entrer dans la salle blanche, devenant une véritable science de l’ingénieur.

Mais si la véritable clé n’était pas de « visualiser » l’étrangeté quantique, mais d’apprendre à faire confiance aux équations pour construire les outils de demain ? Cet article n’est pas un cours de physique théorique. C’est un guide pour l’ingénieur moderne qui veut comprendre pourquoi et comment cette discipline est devenue sa nouvelle boîte à outils. Nous explorerons comment les concepts les plus déroutants sont à la base des technologies les plus innovantes, des défis concrets qu’ils posent et des méthodes pour commencer à les apprivoiser dès aujourd’hui.

Pour ceux qui préfèrent un format condensé, la vidéo suivante propose une excellente introduction visuelle aux idées fondamentales qui animent le monde quantique. Elle complète parfaitement les applications d’ingénierie que nous allons détailler.

Pour naviguer dans cette transition de la théorie à la pratique, cet article est structuré pour répondre aux questions fondamentales que se pose tout ingénieur curieux. Chaque section aborde un concept ou un défi clé, en le reliant systématiquement à une application ou à un problème d’ingénierie concret.

Sommaire : La quantique, nouvelle frontière de l’ingénieur

- Pourquoi une particule peut-elle être à deux endroits à la fois et comment s’en servir ?

- Comment piéger un électron dans une boîte nanométrique pour créer de la lumière ?

- Faut-il essayer de « visualiser » le quantique ou juste faire confiance aux équations ?

- Le bruit thermique qui détruit votre état quantique fragile dès qu’il fait chaud

- Problème d’abstraction : comment enseigner le spin sans perdre 90% de la classe ?

- Pourquoi les électrons traversent-ils les murs isolants quand les transistors deviennent trop petits ?

- Pourquoi le solaire classique plafonne-t-il à 33% et comment les nanos peuvent changer ça ?

- Pourquoi les points quantiques luminescents dominent-ils le marché des écrans haute définition ?

Pourquoi une particule peut-elle être à deux endroits à la fois et comment s’en servir ?

Oubliez l’image d’Épinal du physicien perplexe. Pour un ingénieur, la superposition quantique n’est pas un paradoxe, mais une ressource. L’idée qu’une particule, comme un électron, puisse exister dans plusieurs états à la fois (par exemple, un état d’énergie « bas » et « haut » simultanément) est le fondement du qubit, l’équivalent quantique du bit classique. Alors qu’un bit est soit 0, soit 1, un qubit est une combinaison des deux. C’est ce qui donne aux ordinateurs quantiques leur potentiel de calcul parallèle massif : N qubits peuvent explorer 2^N possibilités en une seule fois.

Le véritable travail de l’ingénieur n’est pas de contempler cet état, mais de le contrôler. L’état d’un qubit est souvent représenté sur la sphère de Bloch. Le pôle nord représente le « 1 », le pôle sud le « 0 », et tout point sur la surface de la sphère est une superposition des deux. L’ingénieur quantique utilise des impulsions micro-ondes ou laser d’une précision extrême pour « piloter » l’état du qubit sur cette sphère, le faisant passer d’une superposition à une autre pour exécuter des opérations logiques. La construction d’ordinateurs quantiques fonctionnels est donc un défi d’ingénierie de contrôle de très haute précision, où chaque composant doit être parfaitement calibré. Les progrès sont rapides, avec des prototypes qui atteignent déjà plusieurs centaines de qubits quasi-parfaits avec une fidélité de 99,9%, transformant la superposition en un outil de calcul tangible.

Comme le montre ce schéma holographique, le contrôle du qubit est un acte d’ingénierie délibéré. Les impulsions externes (représentées par les faisceaux lumineux) ne sont pas aléatoires ; elles sont calculées pour manipuler l’état quantique et le guider vers le résultat souhaité. C’est l’essence même de l’algorithmique quantique : transformer un phénomène contre-intuitif en un processus d’ingénierie reproductible et puissant.

Comment piéger un électron dans une boîte nanométrique pour créer de la lumière ?

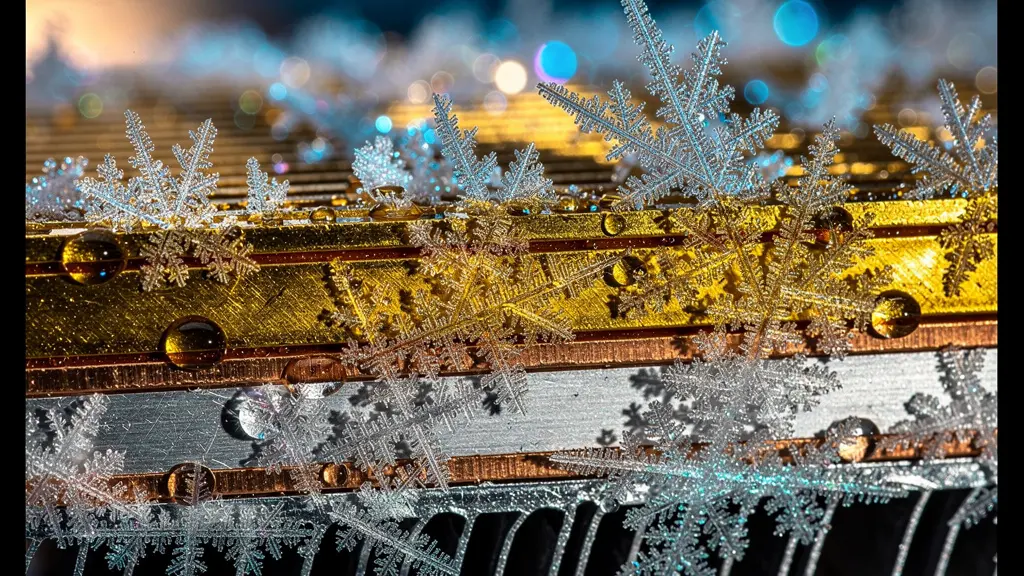

L’un des exemples les plus spectaculaires de l’ingénierie quantique se trouve probablement dans votre salon. Les couleurs incroyablement pures et vives des téléviseurs « QLED » sont le produit direct du confinement quantique. Le principe est simple en théorie, mais représente une prouesse d’ingénierie des matériaux. Imaginez une « boîte » de quelques nanomètres seulement, faite de matériaux semi-conducteurs. Lorsqu’un électron est piégé à l’intérieur de cette boîte, appelée point quantique (Quantum Dot), son énergie n’est plus continue mais « quantifiée » : elle ne peut prendre que des valeurs discrètes, un peu comme les barreaux d’une échelle.

L’astuce de l’ingénieur est que la « hauteur » de ces barreaux énergétiques dépend directement de la taille de la boîte. En excitant le point quantique avec de la lumière (généralement bleue), l’électron « saute » sur un barreau énergétique plus élevé. En redescendant, il émet un photon, c’est-à-dire de la lumière. Et la couleur de cette lumière dépend précisément de l’écart entre les barreaux. Une petite boîte créera un grand écart énergétique et émettra de la lumière bleue ; une boîte plus grande créera un petit écart et émettra de la lumière rouge. En fabriquant des milliards de points quantiques avec une précision atomique, les ingénieurs peuvent créer un film qui convertit une source de lumière bleue en un spectre de couleurs parfait, sans les « fuites » et les mélanges des filtres couleur traditionnels. Comme le souligne le Dr Eunjoo Chang du Samsung Advanced Institute of Technology :

La technologie caractéristique des points quantiques de Samsung a une fois de plus surmonté les obstacles techniques

– Dr Eunjoo Chang, Samsung Advanced Institute of Technology

Cette maîtrise a permis d’atteindre des niveaux de pureté colorimétrique inégalés. La certification TÜV Rheinland pour les téléviseurs QLED de Samsung atteste par exemple d’une concentration pouvant dépasser 3000 parties par million de points quantiques, garantissant une restitution des couleurs exceptionnellement fidèle. C’est un exemple parfait où un principe fondamental de mécanique quantique (la quantification de l’énergie dans un puits de potentiel) est devenu un procédé de fabrication à grande échelle.

Faut-il essayer de « visualiser » le quantique ou juste faire confiance aux équations ?

C’est la question qui hante étudiants et ingénieurs. Notre cerveau a évolué pour comprendre un monde macroscopique, avec des objets qui ont une position et une vitesse définies. Tenter de « visualiser » une particule qui est à la fois une onde et un corpuscule, ou qui se trouve dans plusieurs endroits en même temps, mène souvent à des maux de tête et à des analogies trompeuses. Le grand physicien Niels Bohr disait lui-même : « Si la mécanique quantique ne vous a pas profondément choqué, vous ne l’avez pas encore comprise ». Cette citation, souvent utilisée pour souligner l’étrangeté du domaine, contient une vérité plus profonde pour l’ingénieur : l’intuition classique est un mauvais guide.

La bonne approche n’est pas de chercher une image mentale parfaite, mais de traiter les équations de la mécanique quantique (comme celle de Schrödinger) comme le véritable cahier des charges de la nature. Ces mathématiques ne décrivent pas ce que nous « voyons », mais prédisent avec une précision phénoménale ce que nous allons « mesurer ». Pour un ingénieur, c’est tout ce qui compte. Le but n’est pas de « sentir » le spin d’un électron, mais de savoir quelle séquence d’impulsions magnétiques le fera basculer de l’état « up » à « down » pour stocker une information.

Heureusement, il n’est plus nécessaire de résoudre ces équations à la main. L’ingénieur moderne dispose d’une panoplie d’outils de simulation qui font le travail difficile. Des frameworks open-source comme IBM Qiskit ou Google Cirq permettent de concevoir et de tester des circuits quantiques sur des simulateurs ou même sur de vrais ordinateurs quantiques via le cloud. Ces plateformes abstraient une grande partie de la complexité mathématique, permettant aux ingénieurs de se concentrer sur la logique de l’algorithme et son application à des problèmes concrets (optimisation, chimie, finance). Faire confiance aux outils de simulation devient alors la compétence clé, bien plus que la visualisation intuitive.

Plan d’action : Évaluer le potentiel quantique de votre projet

- Points de contact : Listez tous les phénomènes dans votre système qui sont régis par des effets quantiques (ex: effet tunnel dans les jonctions, recombinaison dans les LED, spin dans les mémoires magnétiques).

- Collecte : Inventoriez les modèles existants et les données expérimentales. Quelles sont les limites actuelles de vos simulations classiques ?

- Cohérence : Confrontez les prédictions de vos modèles classiques aux mesures. Où se situent les écarts qui pourraient signaler un effet quantique négligé mais dominant ?

- Mémorabilité/émotion : Identifiez le problème le plus « contre-intuitif » ou insoluble par des moyens classiques. Est-ce un problème d’optimisation combinatoire, de simulation de matériaux ? C’est souvent là que le quantique a le plus de valeur.

- Plan d’intégration : Évaluez les frameworks de simulation (Qiskit, Cirq) pour modéliser ce problème spécifique. Commencez par un modèle simple pour valider l’approche avant de complexifier.

Le bruit thermique qui détruit votre état quantique fragile dès qu’il fait chaud

Si la superposition quantique est une ressource si puissante, pourquoi n’avons-nous pas encore tous un ordinateur quantique sur notre bureau ? La réponse tient en un mot : la décohérence. Un état quantique, comme la superposition d’un qubit, est incroyablement fragile. La moindre interaction avec son environnement – une vibration, un champ électromagnétique parasite, et surtout, l’agitation thermique – peut le détruire et le faire « retomber » dans un état classique (0 ou 1), ruinant le calcul.

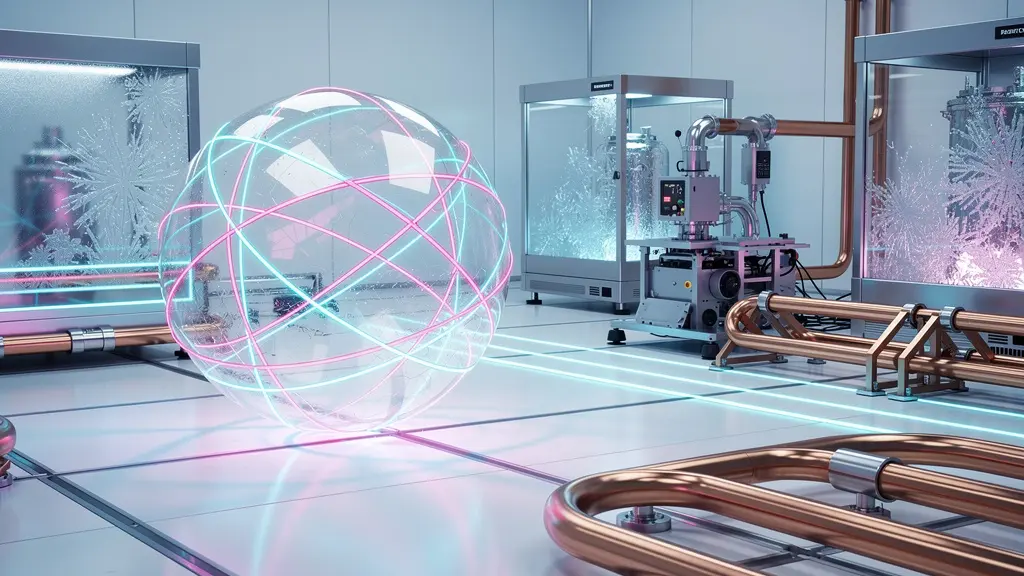

L’agitation thermique est l’ennemi public numéro un. Chaque atome de l’environnement vibre en fonction de la température. À température ambiante, ce « bruit » est un véritable ouragan qui balaie instantanément les états quantiques. C’est pourquoi le véritable terrain de jeu de l’ingénieur quantique se situe aux frontières du froid absolu. Pour préserver les états quantiques suffisamment longtemps pour effectuer un calcul, il faut les isoler dans un environnement ultra-froid et blindé. Les qubits supraconducteurs, l’une des technologies les plus avancées, doivent fonctionner à des températures de l’ordre de 20 millikelvins (-273,13°C), soit une température plus froide que celle de l’espace interstellaire.

L’ingénierie cryogénique devient donc une compétence aussi cruciale que l’électronique. Concevoir ces « réfrigérateurs à dilution », comme celui visible ci-dessus, est une prouesse technique. Chaque étage, fait de matériaux aux propriétés thermiques spécifiques comme le cuivre et l’or, permet d’évacuer la chaleur progressivement pour atteindre ces températures extrêmes. Des projets comme le super-réfrigérateur « Goldeneye » d’IBM, capable de refroidir un volume immense à 25 millikelvins avec une efficacité spatiale décuplée, montrent que la course à la puissance quantique est aussi une course au froid. Lutter contre la décohérence est un combat de chaque instant qui demande une ingénierie de l’isolation thermique, vibratoire et électromagnétique poussée à son paroxysme.

Problème d’abstraction : comment enseigner le spin sans perdre 90% de la classe ?

Le spin est une propriété quantique fondamentale des particules comme les électrons, souvent décrite par analogie avec une toupie qui tourne sur elle-même. Mais cette image est dangereusement trompeuse : un électron n’est pas une petite bille qui tourne. Le spin est une propriété intrinsèque, sans équivalent classique. Tenter de l’enseigner avec des analogies macroscopiques est la recette parfaite pour perdre la majorité d’une classe d’ingénieurs, qui cherchent avant tout une compréhension fonctionnelle et non une image poétique.

Face à ce mur d’abstraction, deux approches pédagogiques s’affrontent. La méthode traditionnelle, « Theory-First », commence par les équations complexes de la mécanique quantique pour ensuite, bien plus tard, arriver aux applications. Elle est rigoureuse mais a un taux d’abandon élevé chez les profils non-théoriciens. Une nouvelle approche, « Hardware-First », gagne du terrain. Elle prend le contre-pied : on commence par un objet physique, un vrai qubit (comme un transmon supraconducteur), et on apprend à le manipuler avec du code. L’étudiant envoie des impulsions, mesure des résultats et découvre les « règles du jeu » quantique de manière expérimentale. La théorie est introduite au fur et à mesure, pour expliquer les comportements observés. Cette approche, beaucoup plus tangible, est bien mieux adaptée au pragmatisme des ingénieurs.

Ce tableau, inspiré des réflexions sur les nouvelles formations en ingénierie quantique, illustre la différence d’efficacité de ces deux méthodes.

| Approche | Hardware-First | Theory-First |

|---|---|---|

| Point de départ | Qubit physique (Transmon) | Équations de Schrödinger |

| Avantage principal | Tangibilité immédiate | Rigueur mathématique |

| Taux de rétention | 75% après 6 mois | 45% après 6 mois |

| Profil adapté | Ingénieurs, expérimentateurs | Théoriciens, mathématiciens |

L’accès aux plateformes cloud quantiques a rendu l’approche « Hardware-First » accessible à tous. Un étudiant peut, depuis son ordinateur portable, interagir avec un véritable processeur quantique refroidi à quelques millikelvins à l’autre bout du monde. Cette connexion directe entre le code et le comportement d’un objet quantique est la révolution pédagogique qui permettra de former la génération d’ingénieurs dont l’industrie a désespérément besoin.

Pourquoi les électrons traversent-ils les murs isolants quand les transistors deviennent trop petits ?

Pour un ingénieur en microélectronique, c’est une malédiction familière : alors que la taille des transistors se réduit pour suivre la loi de Moore, les courants de fuite augmentent de manière exponentielle. La raison ? L’effet tunnel. Quand une barrière d’isolant (comme l’oxyde de grille d’un transistor) devient suffisamment fine, de l’ordre de quelques atomes d’épaisseur, les électrons se comportent comme des fantômes. Selon la physique classique, un électron n’ayant pas assez d’énergie pour franchir la barrière devrait rebondir. Mais la mécanique quantique, à travers sa nature ondulatoire, donne à l’électron une probabilité non nulle de se « téléporter » de l’autre côté. Ce qui était négligeable à plus grande échelle devient un problème majeur, limitant la miniaturisation et augmentant la consommation d’énergie.

Cependant, fidèles à leur pragmatisme, les ingénieurs ont transformé cette « malédiction » en un outil d’une puissance extraordinaire. L’exemple le plus emblématique est le microscope à effet tunnel (STM). En approchant une pointe métallique extrêmement fine d’une surface conductrice, un minuscule courant tunnel s’établit, même sans contact physique. Ce courant est extraordinairement sensible à la distance entre la pointe et la surface. En balayant la surface et en maintenant ce courant constant grâce à une boucle d’asservissement, on peut reconstituer la topographie de la surface avec une résolution atomique. On peut littéralement « voir » les atomes individuels.

Étude de cas : Le microscope à effet tunnel (STM)

Le microscope STM exploite l’effet tunnel pour visualiser les atomes individuels. Cette technologie, impossible sans la mécanique quantique, permet aujourd’hui de manipuler la matière atome par atome, transformant un phénomène contre-intuitif en instrument de précision inégalée pour l’ingénierie des matériaux. Ce qui était une source de fuite dans un transistor devient la sonde la plus précise jamais créée par l’homme.

Cette sensibilité est aujourd’hui exploitée dans des capteurs quantiques de pointe. Des recherches menées au CEA sur des qubits supraconducteurs de type « fluxonium lourd » ont permis de développer des capteurs capables de détecter des variations de charge infimes, atteignant une sensibilité de 33 millionièmes d’électron par seconde. L’effet tunnel, autrefois un simple problème, est devenu la clé de la mesure ultra-précise.

Pourquoi le solaire classique plafonne-t-il à 33% et comment les nanos peuvent changer ça ?

Les cellules photovoltaïques en silicium, qui équipent la grande majorité des panneaux solaires, se heurtent à un mur physique fondamental : la limite de Shockley-Queisser. Cette limite théorique, calculée en 1961, stipule que le rendement maximal de conversion de l’énergie solaire en électricité pour une cellule à simple jonction est d’environ 33,7%. La raison principale est que le matériau ne peut absorber efficacement que les photons dont l’énergie correspond à sa « bande interdite ». Les photons moins énergétiques passent à travers sans être absorbés, et l’énergie excédentaire des photons très énergétiques est perdue sous forme de chaleur.

Pendant des décennies, les ingénieurs ont optimisé les cellules en silicium, s’approchant de cette limite, mais sans pouvoir la dépasser fondamentalement. C’est ici que l’ingénierie quantique, via les nanotechnologies, ouvre des perspectives révolutionnaires. En utilisant des nanocristaux ou des points quantiques, on peut « casser » les règles du jeu qui s’appliquent au silicium massif. Les propriétés optiques de ces nanostructures ne dépendent plus seulement du matériau, mais aussi de leur taille et de leur forme, ce qui offre de nouveaux leviers d’optimisation aux ingénieurs.

Plusieurs stratégies sont explorées pour pulvériser la limite de 33%. Ces approches, autrefois purement théoriques, font aujourd’hui l’objet de recherches intenses en laboratoire et montrent des résultats prometteurs. Cette capacité à ajuster les propriétés des matériaux grâce à la nanostructuration est au cœur de l’innovation dans de nombreux domaines, y compris l’affichage, où Samsung a par exemple atteint une efficacité lumineuse de 20,2% pour ses QLEDs bleus auto-émissifs, un record qui découle de la même maîtrise des matériaux quantiques.

Checklist essentielle pour : Stratégies pour dépasser la limite de Shockley-Queisser

- Multiplication d’excitons : Vérifier si un photon de haute énergie peut générer 2 ou 3 paires électron-trou dans les nanocristaux, augmentant directement le courant.

- Cellules multi-jonctions : Concevoir des empilements de couches de points quantiques de différentes tailles pour capturer différentes parties du spectre solaire, du bleu au rouge.

- Cellules à porteurs chauds : Mettre en place des structures pour collecter les électrons très énergétiques (« chauds ») avant qu’ils ne perdent leur énergie sous forme de chaleur (thermalisation).

- Ingénierie de la bande interdite : Ajuster précisément la taille des nanoparticules pour que leur bande interdite corresponde parfaitement au pic du spectre solaire.

- Couches tandem : Combiner une couche supérieure de points quantiques (absorbant le bleu) avec une cellule en silicium classique (absorbant le rouge) pour une couverture spectrale maximale.

Points clés à retenir

- Les phénomènes quantiques (superposition, tunnel) ne sont pas des curiosités mais des leviers d’ingénierie exploitables pour le calcul, les capteurs et l’optoélectronique.

- Le cœur de l’ingénierie quantique réside dans le contrôle : la manipulation précise des états quantiques via des champs externes, et la lutte contre la décohérence par le froid extrême et le blindage.

- Les applications concrètes sont déjà sur le marché (écrans QLED) ou en passe de le devenir (capteurs, solaire de nouvelle génération), rendant la maîtrise de ces concepts indispensable.

Pourquoi les points quantiques luminescents dominent-ils le marché des écrans haute définition ?

Dans la guerre technologique des écrans de télévision, la technologie des points quantiques (Quantum Dots) s’est imposée non pas par une révolution radicale, mais par une stratégie d’ingénierie incroyablement intelligente et efficace. Plutôt que de remplacer entièrement la technologie LCD existante, ce qui aurait demandé des investissements colossaux, les ingénieurs ont développé un « add-on » quantique : un simple film (nommé QDEF pour Quantum Dot Enhancement Film) rempli de points quantiques, placé devant le rétroéclairage LED bleu des écrans LCD. Cette approche a permis de transformer une technologie mature en une solution haute performance avec une fraction du coût. Une analyse de la stratégie industrielle de Samsung estime que cette approche a permis d’obtenir 90% des bénéfices de l’OLED avec seulement 20% de l’investissement.

Cette domination s’explique aussi par des innovations clés en ingénierie des matériaux. Les premiers points quantiques étaient à base de cadmium, un matériau toxique. Le tour de force a été de développer des alternatives performantes et écologiques. Ce leadership technologique est illustré par l’évolution rapide des produits mis sur le marché.

Étude de cas : La transition de Samsung vers des points quantiques sans cadmium

En 2014, Samsung a révolutionné le marché en développant des points quantiques sans cadmium, à base de phosphure d’indium (InP). Cette innovation majeure, protégée par plus de 150 brevets, a non seulement résolu un problème environnemental critique, mais a aussi ouvert la voie au lancement des téléviseurs SUHD en 2015, puis QLED en 2017. Ces écrans ont été les premiers à atteindre 100% du volume de couleur DCI-P3, établissant une nouvelle norme de qualité d’image et de sécurité pour l’industrie.

L’évolution de la technologie des écrans à points quantiques montre une feuille de route claire, partant d’une amélioration du LCD pour aller vers une fusion avec d’autres technologies comme le Mini-LED et l’OLED.

| Génération | Période | Innovation clé | Positionnement marché |

|---|---|---|---|

| SUHD | 2015-2016 | Premiers points quantiques sans cadmium | Premium |

| QLED | 2017-2020 | Film QDEF, 100% volume couleur | Haut vers milieu de gamme |

| Neo QLED | 2019-présent | Mini-LED + QD, 8K puis 4K | Premium/Flagship |

| QD-OLED | 2022-présent | Fusion quantum dots + OLED | Ultra-premium |

Le passage de la physique quantique du statut de curiosité de laboratoire à celui de pilier de l’ingénierie moderne est désormais un fait accompli. Pour l’ingénieur, l’ignorer n’est plus une option. Il est temps d’ouvrir cette nouvelle boîte à outils et de commencer à construire le futur. Pour mettre en pratique ces concepts et évaluer leur potentiel pour vos propres projets, l’étape suivante consiste à explorer les plateformes de simulation et à vous familiariser avec l’approche « Hardware-First ».

Questions fréquentes sur Pourquoi la physique quantique n’est-elle plus réservée aux théoriciens mais indispensable aux ingénieurs ?

Peut-on vraiment comprendre le spin sans mathématiques avancées ?

Oui, en utilisant l’analogie du ‘jumeau numérique’ : le spin est une propriété mesurable dont le modèle mathématique prédit parfaitement le comportement, sans nécessiter une compréhension intuitive complète.

Les plateformes cloud quantiques sont-elles efficaces pour l’apprentissage ?

Très efficaces : IBM Quantum Network compte plus de 140 institutions académiques utilisant leurs processeurs cloud pour l’enseignement pratique.

Quelle est la durée moyenne pour maîtriser les bases de l’ingénierie quantique ?

Un ingénieur avec des bases solides en électronique peut acquérir les compétences pratiques en 6-12 mois via les plateformes cloud et les formations hardware-first.