La course à la performance ne se joue plus sur la finesse de gravure, mais sur la maîtrise des contraintes physiques fondamentales.

- La gestion de la densité thermique dans les architectures 3D est devenue le principal goulot d’étranglement.

- Le contrôle des fuites de courant via des architectures hétérogènes et des transistors avancés (GAA) est critique pour l’efficience énergétique.

Recommandation : L’investissement stratégique doit se porter sur les outils de simulation quantique (TCAD) et les technologies de refroidissement avancées pour débloquer les futurs gains de performance.

Depuis des décennies, l’industrie des semi-conducteurs a fonctionné sur un postulat simple : tous les deux ans, la densité des transistors sur une puce double, augmentant la puissance de calcul de manière exponentielle. Cette prophétie, connue sous le nom de loi de Moore, a été le moteur de la révolution numérique. Aujourd’hui, ce moteur tousse. La fréquence des processeurs stagne, non pas par manque d’ambition, mais parce que nous nous heurtons aux limites fondamentales de la physique du silicium. À l’échelle nanométrique, les électrons ne se comportent plus comme des billes bien sages, mais comme des ondes probabilistes capables de traverser des murs isolants.

Face à ce mur, les réponses conventionnelles parlent d’empilement 3D, de nouveaux matériaux comme le graphène ou de l’avènement lointain de l’informatique quantique. Si ces pistes sont valides, elles masquent le défi immédiat et bien plus complexe pour les architectes de processeurs et les fabricants de puces. Le véritable enjeu n’est plus seulement de miniaturiser, mais de repenser entièrement la conception des puces pour dompter une physique devenue contre-intuitive. Il s’agit de transformer des « problèmes » quantiques en opportunités et de gérer des contraintes thermiques et énergétiques qui étaient autrefois secondaires.

Cet article s’écarte des généralités pour plonger au cœur des verrous technologiques et des solutions d’ingénierie qui définissent aujourd’hui la course à la performance. La question n’est plus de savoir si la loi de Moore est morte, mais de comprendre comment les ingénieurs la contournent en devenant des maîtres de la physique à l’échelle atomique. Nous allons décortiquer les problèmes concrets de fuite de courant, de dissipation thermique, d’usure matérielle et de coût de production, et analyser les stratégies qui permettent de continuer à innover.

Pour naviguer au cœur de ces défis d’ingénierie, cet article est structuré pour aborder chaque verrou technologique de manière méthodique. Des effets quantiques dans les transistors aux contraintes économiques de la production, nous explorerons les solutions qui façonnent l’avenir de la microélectronique.

Sommaire : Les nouvelles frontières de la conception des semi-conducteurs

- Pourquoi les électrons traversent-ils les murs isolants quand les transistors deviennent trop petits ?

- Comment évacuer la chaleur d’un processeur dont les cœurs sont empilés les uns sur les autres ?

- Transistor au Silicium ou au Graphène : lequel dominera l’informatique de 2035 ?

- L’usure invisible qui coupe les connexions internes de vos processeurs après 5 ans d’usage intensif

- Problème de fuite de courant : la solution nano pour des appareils qui tiennent 1 mois sur batterie

- Pourquoi la lithographie extrême UV coûte-t-elle 150 millions d’euros par machine ?

- Problème de coût : comment passer de 50% à 99% de puces fonctionnelles par wafer ?

- Pourquoi la physique quantique n’est-elle plus réservée aux théoriciens mais indispensable aux ingénieurs ?

Pourquoi les électrons traversent-ils les murs isolants quand les transistors deviennent trop petits ?

Lorsque la taille d’un transistor atteint l’échelle nanométrique, les lois de la physique classique cèdent la place à celles de la mécanique quantique. Le principal obstacle est l’effet tunnel quantique. Dans un transistor classique, une « porte » (la grille) bloque ou autorise le passage du courant. Mais quand l’isolant de cette porte devient extrêmement fin, les électrons, se comportant comme des ondes, ont une probabilité non nulle de le « traverser » même lorsque la porte est fermée. Ce phénomène génère des courants de fuite, augmentant la consommation d’énergie et la chaleur sans produire de travail utile. Ce n’est plus un défaut marginal, mais un comportement fondamental du composant.

La barrière critique est aujourd’hui bien identifiée. Une étude de modélisation quantique montre que des transistors avec une longueur de grille inférieure à 7 nanomètres voient leurs performances sévèrement dégradées par cet effet tunnel incontrôlé. Plutôt que de combattre frontalement ce phénomène, l’ingénierie moderne cherche à le maîtriser, voire à l’utiliser. Le défi n’est plus d’empêcher le tunnel, mais de concevoir des structures de transistor où ce comportement devient prédictible et gérable. C’est un changement de paradigme complet, comme le souligne un expert du domaine.

Comme l’explique Marc Bescond dans sa thèse sur le transport quantique :

Il ne s’agit pas pour l’ingénieur de construire un ordinateur quantique, mais d’utiliser la mécanique quantique pour modéliser et prédire le comportement des électrons dans les transistors classiques de 3 nanomètres.

– Marc Bescond, Thèse sur le transport quantique dans les transistors MOS nanométriques

Cette approche transforme la physique quantique d’un obstacle en un outil de conception. En intégrant ces simulations dans les logiciels de conception assistée par ordinateur (CAO), les ingénieurs peuvent anticiper les courants de fuite et optimiser la géométrie des transistors (comme les architectures FinFET ou Gate-All-Around) pour minimiser leur impact, assurant ainsi la viabilité des futures générations de puces.

Comment évacuer la chaleur d’un processeur dont les cœurs sont empilés les uns sur les autres ?

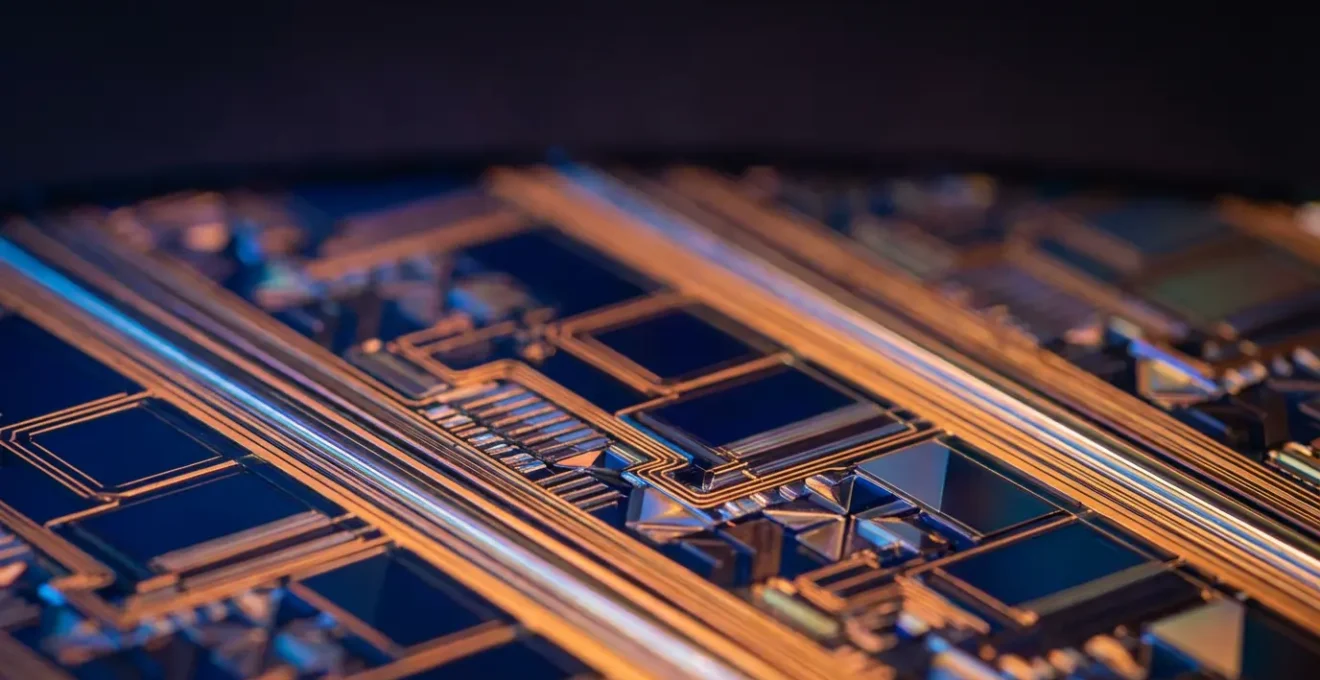

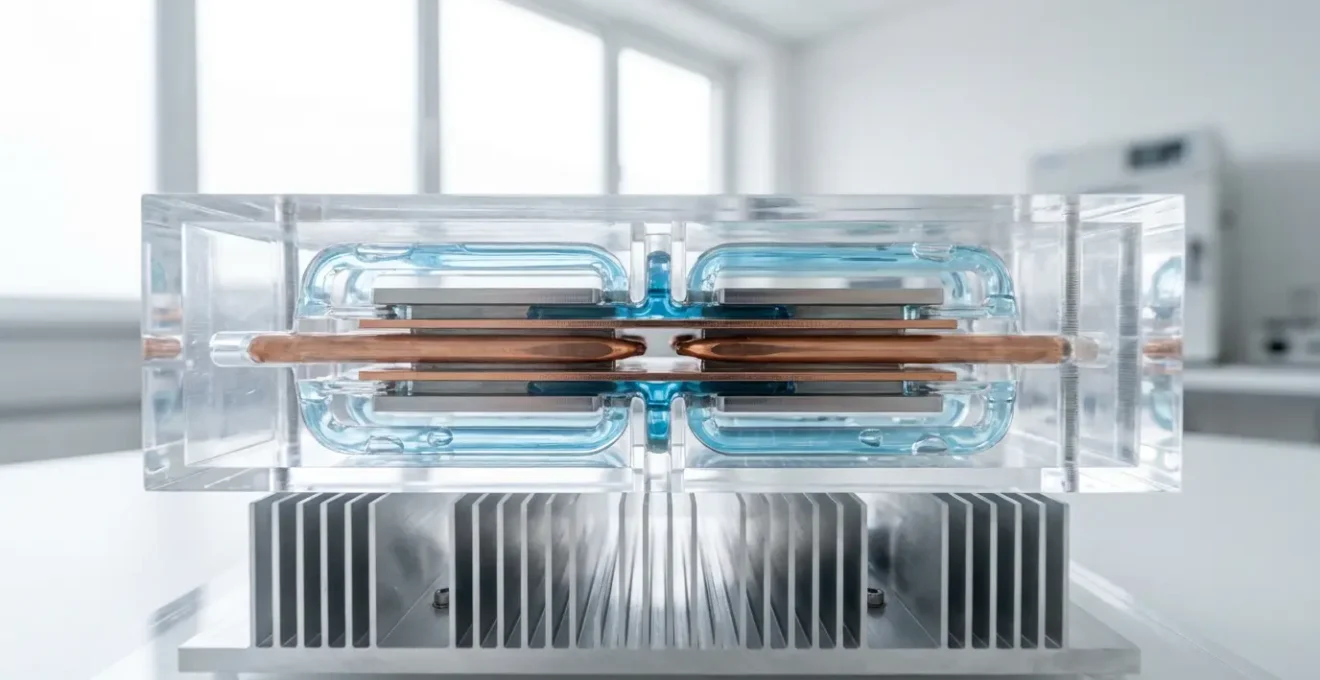

L’empilement vertical de puces (ou 3D stacking) est une réponse logique à la stagnation de la miniaturisation horizontale. En superposant les cœurs, on réduit la distance entre eux, ce qui diminue la latence et augmente la bande passante. Cependant, cette stratégie crée un cauchemar thermique : la densité de puissance thermique explose. Chaque couche de silicium produit de la chaleur, et cette chaleur doit traverser les couches inférieures pour être évacuée, transformant le processeur en un gratte-ciel difficile à refroidir. Les méthodes traditionnelles de refroidissement par air, déjà poussées à leurs limites, deviennent totalement inefficaces.

Le problème est d’autant plus critique à grande échelle. Des données industrielles révèlent que jusqu’à 40% de la consommation électrique d’un datacenter est dédiée uniquement au refroidissement des serveurs. L’empilement 3D, s’il n’est pas accompagné d’une révolution du refroidissement, ne ferait qu’aggraver cette facture énergétique. La solution réside dans l’intégration de systèmes de refroidissement directement au cœur de la puce. On ne refroidit plus le processeur de l’extérieur, mais de l’intérieur.

L’une des approches les plus prometteuses est le refroidissement liquide direct, avec des micro-canaux gravés entre les couches de silicium, comme le montre l’illustration ci-dessus. Un fluide caloporteur circule au plus près des sources de chaleur pour l’extraire avec une efficacité bien supérieure à celle de l’air. Certains acteurs vont même plus loin, comme le démontre une expérimentation à grande échelle. Microsoft a testé avec succès des serveurs complètement immergés dans des réservoirs de liquide diélectrique, une technique qui, selon une analyse sur le refroidissement par immersion, offre une dissipation thermique jusqu’à 1000 fois plus efficace que l’air, ouvrant la voie à des puces 3D bien plus denses et performantes.

Transistor au Silicium ou au Graphène : lequel dominera l’informatique de 2035 ?

Le silicium, pilier de la microélectronique depuis 60 ans, atteint ses limites physiques. La recherche de son successeur est une course mondiale où plusieurs matériaux aux propriétés extraordinaires sont en lice. Le candidat le plus médiatisé est le graphène, une feuille de carbone d’un atome d’épaisseur, vanté pour sa mobilité électronique exceptionnelle, bien supérieure à celle du silicium. Cependant, son principal défaut est l’absence de « bande interdite » (band gap) naturelle, ce qui signifie qu’un transistor en graphène ne peut pas être complètement « éteint », entraînant des fuites de courant massives. D’autres matériaux, comme les nanotubes de carbone (CNT) ou les dichalcogénures de métaux de transition (TMD) tel le MoS2, offrent des compromis intéressants.

Le tableau suivant synthétise les forces et faiblesses des principaux candidats face au silicium, dont l’écosystème industriel reste le principal atout.

| Matériau | Avantages | Inconvénients | Maturité technologique |

|---|---|---|---|

| Silicium (Si) | Écosystème industriel mature, procédés maîtrisés | Limites physiques atteintes sous 5nm | Production de masse |

| Graphène | Mobilité électronique exceptionnelle | Absence de bande interdite naturelle | Recherche avancée |

| Nanotubes de carbone (CNT) | Propriétés électriques modulables | Difficultés de production uniforme | Prototypes |

| MoS2 (TMD) | Bande interdite naturelle, compatible 2D | Mobilité plus faible que le graphène | Recherche fondamentale |

Plutôt que d’attendre un matériau miracle, la stratégie actuelle consiste à repousser les limites du silicium en exploitant des phénomènes quantiques. Une approche fascinante est l’utilisation de l’interférence quantique destructive. Comme l’explique le Dr James Thomas dans une publication de recherche parue dans Nature Nanotechnology, cette technique permet de « créer un ‘mur’ quantique qui élimine le flux d’électrons de fuite » lorsque le transistor est éteint. En somme, on utilise un effet quantique pour en annuler un autre. Cette maîtrise fine de la physique pourrait prolonger la domination du silicium, ou d’alliages comme le silicium-germanium (SiGe), bien au-delà des prédictions initiales.

L’usure invisible qui coupe les connexions internes de vos processeurs après 5 ans d’usage intensif

La performance d’un processeur n’est pas seulement limitée par la physique quantique, mais aussi par un phénomène d’usure bien plus matériel : l’électromigration. Ce processus est la migration progressive des atomes de métal (généralement du cuivre ou de l’aluminium) qui composent les interconnexions à l’intérieur de la puce. Sous l’effet du « vent d’électrons » d’un courant électrique à haute densité, ces atomes sont littéralement poussés, créant des vides d’un côté et des accumulations de l’autre. À terme, ces vides peuvent couper une connexion, tandis que les accumulations peuvent créer des courts-circuits, menant à une défaillance de la puce.

Ce phénomène est directement exacerbé par deux facteurs clés de la course à la performance : la densité de courant et la température. Plus les fils sont fins pour connecter des milliards de transistors, plus la densité de courant augmente. De même, chaque augmentation de la fréquence d’horloge, surtout en overclocking, augmente la température et le flux d’électrons, accélérant drastiquement l’usure. Les records de fréquence sont souvent obtenus dans des conditions extrêmes qui illustrent ce stress. Par exemple, Intel a atteint des fréquences spectaculaires, mais au prix de contraintes énormes sur le matériel.

Dans cette quête de performance pure, les laboratoires repoussent constamment les limites, démontrant l’impact crucial de la température. IBM, en collaboration avec Georgia Tech, a par exemple établi un record de 500 GHz avec un transistor en silicium-germanium, mais en le refroidissant à une température cryogénique de -269°C. À température ambiante, le même transistor fonctionnait « seulement » à 350 GHz. Ces expériences extrêmes, bien qu’impressionnantes, soulignent que la fiabilité à long terme sous une charge intensive et à des températures opérationnelles normales est un défi d’ingénierie majeur, nécessitant des alliages plus robustes et des modèles prédictifs d’usure de plus en plus sophistiqués.

Problème de fuite de courant : la solution nano pour des appareils qui tiennent 1 mois sur batterie

La consommation énergétique est le nerf de la guerre, en particulier pour les appareils mobiles. Une grande partie de cette consommation ne vient pas du calcul actif, mais des fuites de courant (leakage), ce « bruit de fond » électrique où les transistors consomment de l’énergie même au repos. Avec des milliards de transistors sur une puce, ces fuites cumulées peuvent vider une batterie rapidement. La miniaturisation a aggravé ce problème : des grilles plus petites offrent un moins bon contrôle sur le canal du transistor, facilitant ces fuites. La performance par watt, et non plus la fréquence brute, est devenue la métrique reine.

Pour contrer ce phénomène, les architectes de processeurs ont développé des stratégies sophistiquées. L’une des plus efficaces est l’architecture hétérogène, popularisée par ARM avec son concept « big.LITTLE ». L’idée est de combiner sur une même puce deux types de cœurs : des cœurs « haute performance » (gros et rapides, mais énergivores) et des cœurs « haute efficacité » (petits et plus lents, mais très économes). Le système d’exploitation bascule intelligemment les tâches vers le type de cœur le plus approprié : les tâches légères tournent sur les cœurs efficients, préservant la batterie, tandis que les applications exigeantes activent les cœurs performants.

Au-delà de l’architecture, la lutte contre les fuites se joue au niveau du transistor lui-même. Plusieurs techniques sont combinées pour un contrôle maximal :

- Matériaux diélectriques high-k : Utilisation de matériaux avec une permittivité diélectrique élevée pour l’isolant de la grille, ce qui permet de l’épaissir physiquement tout en conservant ses propriétés électriques, réduisant ainsi l’effet tunnel.

- Transistors FinFET et GAA (Gate-All-Around) : Ces architectures 3D de transistor enveloppent le canal sur trois côtés (FinFET) ou entièrement (GAA), donnant à la grille un contrôle électrostatique bien supérieur et « étouffant » les fuites de courant.

- Gestion dynamique de la tension : Ajustement en temps réel de la tension d’alimentation et de la tension de seuil des transistors en fonction de la charge de travail pour fournir juste assez d’énergie, et pas plus.

- Modes de veille profonde : Capacité à couper entièrement l’alimentation de blocs entiers de la puce lorsqu’ils ne sont pas utilisés.

Pourquoi la lithographie extrême UV coûte-t-elle 150 millions d’euros par machine ?

Pour graver des circuits de plus en plus fins, il faut une lumière avec une longueur d’onde de plus en plus courte. La photolithographie a ainsi évolué, passant de la lumière visible à l’ultraviolet profond (DUV). Aujourd’hui, pour graver des motifs inférieurs à 7 nanomètres, l’industrie s’est tournée vers la lithographie extrême UV (EUV). Le défi est immense : produire et manipuler une lumière à 13,5 nanomètres de longueur d’onde, si énergétique qu’elle est absorbée par presque tout, y compris l’air et les lentilles en verre traditionnelles. Cela explique en partie le coût astronomique des machines, qui sont de véritables merveilles d’ingénierie.

Le prix initial de 150 millions d’euros est déjà obsolète. La dernière génération de machines, dites « High-NA » (à haute ouverture numérique), qui permettront de graver les puces de la prochaine décennie, atteint des sommets. Selon les annonces d’ASML en 2024, le fabricant quasi-monopolistique de ces équipements, le prix d’une seule de ces machines s’élève désormais à 350 millions d’euros. Chaque machine pèse 180 tonnes et nécessite plusieurs Boeing 747 pour être transportée.

Le cœur de cette complexité réside dans la source de lumière. Il n’existe pas de « lampe » EUV. La lumière est créée en vaporisant de minuscules gouttelettes d’étain avec un laser surpuissant. Le processus, développé par ASML, est d’une précision inouïe : 50 000 gouttelettes d’étain de 25 micromètres de diamètre sont projetées chaque seconde. Un premier laser de faible puissance aplatit chaque gouttelette en forme de disque. Puis, un second laser CO2, extrêmement puissant, la pulvérise. Cette vaporisation crée un plasma qui émet de la lumière EUV. Tout ce processus se déroule dans un vide quasi-parfait, et la lumière est ensuite guidée par une série de miroirs ultra-polis, car les lentilles l’absorberaient. C’est, à toutes fins utiles, un réacteur à étoiles miniature opérant dans une salle blanche.

Problème de coût : comment passer de 50% à 99% de puces fonctionnelles par wafer ?

Produire des puces à l’échelle nanométrique est un processus intrinsèquement imparfait. Sur une galette de silicium (« wafer ») contenant des centaines de puces identiques, une partie sera toujours défectueuse à cause de la moindre poussière ou d’une imperfection dans le processus de gravure. Le pourcentage de puces fonctionnelles sur un wafer est appelé le rendement (yield). Lorsque les technologies sont nouvelles et les gravures très fines, le rendement peut être dramatiquement bas, parfois inférieur à 50%. Chaque puce jetée représente une perte sèche, faisant grimper le coût unitaire des puces fonctionnelles. L’optimisation du rendement est donc un enjeu économique aussi crucial que la performance brute.

Atteindre un rendement proche de 99% est l’objectif ultime de tout fondeur. Cela ne s’obtient pas par un seul miracle, mais par une accumulation de stratégies d’optimisation, de contrôle et de réparation. L’intelligence artificielle joue un rôle de plus en plus central dans ce processus, en permettant une détection précoce des anomalies et une correction en temps réel des paramètres de fabrication. Un contrôle statistique des procédés (SPC) rigoureux permet de s’assurer que chaque étape, des centaines que compte la fabrication, reste dans des tolérances extrêmement serrées.

Plutôt que de simplement jeter les puces défectueuses, l’industrie a développé des techniques pour les « sauver » ou les valoriser, maximisant ainsi la rentabilité de chaque wafer.

Plan d’action pour l’optimisation du rendement des wafers

- Mise en œuvre du « binning » : Catégoriser les puces en fonction de leurs défauts. Une puce dont une partie du cache est défectueuse peut être vendue comme un modèle de gamme inférieure avec moins de cache, au lieu d’être jetée.

- Intégration de la redondance : Inclure des circuits de rechange (lignes de mémoire, blocs logiques) directement sur la puce. Si un défaut est détecté lors des tests, ces circuits redondants peuvent être activés (souvent par découpe laser) pour remplacer la partie défectueuse.

- Optimisation des paramètres de lithographie : Utiliser des modèles de simulation pour ajuster finement les paramètres de la machine EUV pour chaque couche spécifique du wafer, afin de compenser les variations infimes et d’améliorer la précision de la gravure.

- Détection précoce par l’IA : Déployer des systèmes d’inspection optique automatisée et d’analyse d’images basés sur l’IA pour repérer les défauts potentiels en cours de production, bien avant le test final.

- Implémentation du contrôle statistique des procédés (SPC) : Monitorer en temps réel des milliers de variables (température, pression, composition chimique) et utiliser des algorithmes statistiques pour détecter les dérives avant qu’elles ne causent des défauts.

À retenir

- La physique quantique n’est plus une barrière infranchissable mais un outil de conception que les ingénieurs doivent maîtriser via la simulation (TCAD).

- La gestion de la densité thermique, et non la miniaturisation, est devenue le principal goulot d’étranglement des architectures 3D, rendant les solutions de refroidissement liquide critiques.

- La performance économique (coût par puce) est désormais indissociable de la performance technique, pilotée par le coût de la lithographie EUV et le rendement de production (yield).

Pourquoi la physique quantique n’est-elle plus réservée aux théoriciens mais indispensable aux ingénieurs ?

L’idée que la physique quantique ne concerne que les chercheurs en physique fondamentale est une vision dépassée. Pour les ingénieurs concevant les transistors de demain, les effets quantiques ne sont plus une curiosité théorique, mais une réalité quotidienne qui dicte la performance, la consommation et la fiabilité de leurs créations. Dans les architectures de transistors modernes comme les FinFET ou les Gate-All-Around (GAA), le canal de silicium où circulent les électrons est si fin qu’il ne mesure plus que quelques dizaines d’atomes de large. À cette échelle, le comportement des électrons est entièrement régi par les lois quantiques.

Cette réalité change fondamentalement le travail de l’ingénieur. Comme le souligne une analyse des architectures émergentes, le confinement quantique dans ces canaux ultra-fins affecte directement la mobilité des électrons et la résistance du canal, deux paramètres qui déterminent la vitesse et l’efficacité du transistor. Ignorer ces effets conduit à des prédictions de performance totalement erronées. Le transistor ne se comporte plus comme un simple interrupteur, mais comme un système quantique complexe.

Dans les transistors FinFET ou GAA (Gate-All-Around), le canal de silicium est si fin que le comportement des électrons est dicté par des règles quantiques, ce qui affecte directement leur mobilité et la performance de la puce.

– Équipe de recherche, Analyse des architectures multi-grilles émergeantes

Cette transition a forcé une adaptation rapide des compétences et des outils. L’ingénieur en microélectronique d’aujourd’hui doit être un profil hybride, à l’aise avec l’ingénierie électrique, la science des matériaux et les concepts de physique quantique. Les entreprises et les universités investissent massivement dans la formation de ces nouveaux talents, capables de manipuler des logiciels de simulation TCAD (Technology Computer-Aided Design) qui modélisent le comportement quantique des électrons. Ces outils permettent de tester virtuellement des milliers de géométries de transistors et de matériaux avant de lancer un cycle de production coûteux, faisant de la simulation quantique le pilier de l’innovation dans les semi-conducteurs.

Pour conserver une avance compétitive dans l’ère post-Moore, l’étape suivante consiste à investir massivement dans les compétences hybrides d’ingénierie-physique et dans les plateformes de simulation avancées qui permettent de maîtriser ces nouvelles complexités.