Le nanovecteur parfait n’existe pas ; le succès d’une thérapie ciblée réside dans le choix du bon compromis technologique.

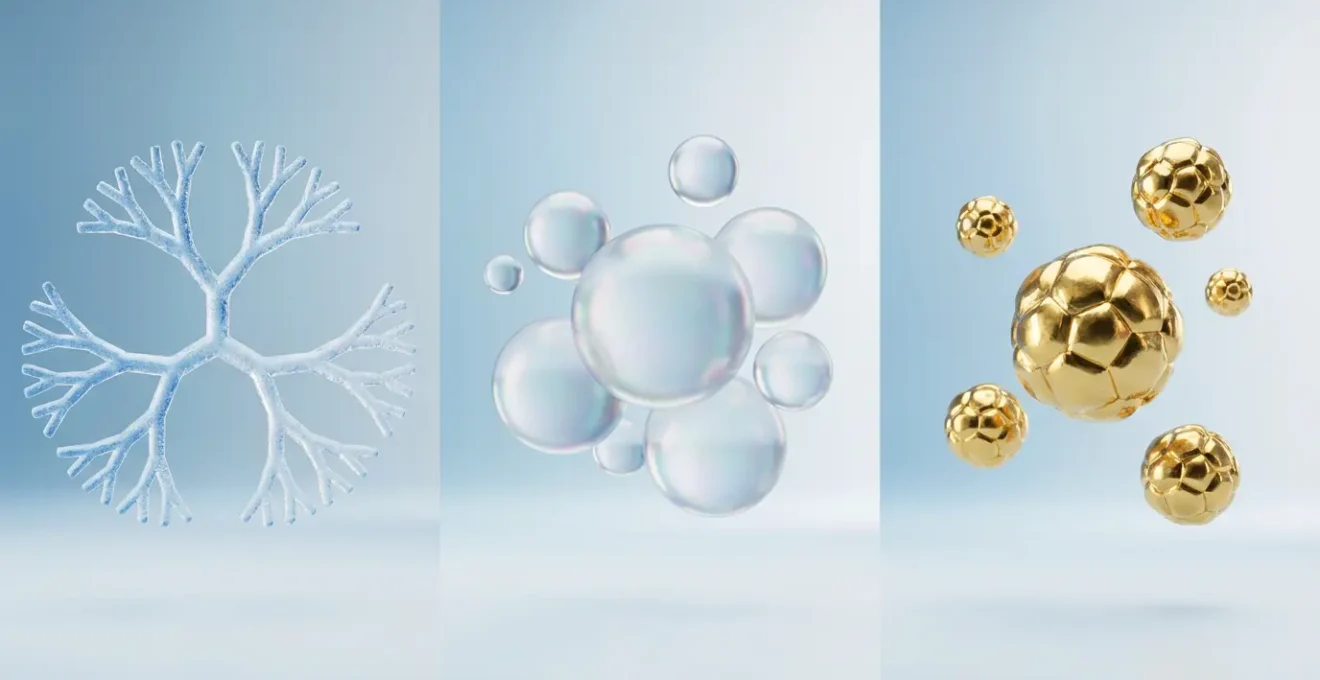

- Les dendrimères offrent une charge médicamenteuse multiple et une grande stabilité, mais leur capacité d’emport reste limitée.

- Les liposomes, leaders du marché, excellent par leur biocompatibilité et leur efficacité pour encapsuler l’ARN, au prix d’une plus grande fragilité.

- Les nanoparticules inorganiques (or, silice) ouvrent la voie à la théranostique (diagnostic + thérapie), mais posent la question de leur bio-persistance à long terme.

Recommandation : Analyser en priorité l’adéquation entre la nature du principe actif, la cible biologique et les contraintes de production industrielle avant de sélectionner une plateforme de vectorisation.

Transformer un poison en remède ciblé. Tel est le paradoxe fondamental et la promesse de la nanomédecine. Depuis des décennies, des traitements comme la chimiothérapie luttent contre des maladies agressives au prix d’une toxicité systémique dévastatrice pour les tissus sains. L’enjeu n’est plus seulement de découvrir de nouvelles molécules actives, mais de maîtriser leur voyage dans l’organisme pour qu’elles n’agissent qu’à l’endroit voulu, au moment voulu. C’est ici qu’intervient la vectorisation, l’art de concevoir des « véhicules » nanométriques capables de transporter et de délivrer des principes actifs avec une précision inégalée. Cette approche a déjà permis une augmentation de précision des traitements de l’ordre de 28%, élargissant considérablement la fenêtre thérapeutique de nombreux médicaments.

Face à ce potentiel, la question qui se pose aux chercheurs et aux investisseurs n’est plus « faut-il vectoriser ? » mais « comment et avec quoi ? ». Le débat se focalise souvent sur la supériorité d’une technologie sur une autre. Or, la réalité du développement thérapeutique est plus nuancée. Choisir entre un dendrimère, une sphère lipidique ou une bille d’or n’est pas une simple préférence technologique ; c’est un arbitrage stratégique complexe entre capacité de charge, biocompatibilité, stabilité, mécanisme de libération et, point crucial souvent sous-estimé, la capacité à industrialiser le procédé selon les normes GMP (Good Manufacturing Practices). Chaque plateforme de délivrance représente un faisceau de compromis qu’il faut évaluer à l’aune de l’indication thérapeutique visée. Cet article propose une analyse comparative de ces nanovecteurs, non pas pour couronner un vainqueur, mais pour équiper les décideurs des clés de lecture nécessaires à un arbitrage éclairé.

Pour naviguer dans ce paysage technologique complexe, cet article décrypte les avantages et les inconvénients des principales familles de nanovecteurs. Nous analyserons les arbitrages fondamentaux auxquels tout développeur de nanomédicament est confronté.

Sommaire : Analyse stratégique des plateformes de nanovectorisation

- Comment la vectorisation de médicaments transforme-t-elle des poisons en remèdes ciblés ?

- Pourquoi ces molécules en forme d’arbre sont-elles idéales pour transporter plusieurs médicaments à la fois ?

- Comment mélanger des lipides et de l’ARN pour créer une sphère protectrice stable ?

- Comment un gel nanométrique peut-il gonfler et libérer son contenu en changeant de pH ?

- Billes d’or ou de latex : quel marqueur choisir pour un test de grossesse ultra-sensible ?

- Carbone biodégradable ou Silice persistante : quel risque accepter pour sauver un patient ?

- L’erreur de surface qui attire les protéines du sang et neutralise votre nanovecteur

- Quand arrêter la synthèse artisanale pour passer aux réacteurs de nanovecteurs GMP ?

Comment la vectorisation de médicaments transforme-t-elle des poisons en remèdes ciblés ?

Le concept fondamental de la vectorisation repose sur l’élargissement de la fenêtre thérapeutique. Pour de nombreux médicaments puissants, notamment en oncologie, la dose efficace est très proche de la dose toxique. En encapsulant le principe actif dans un nanovecteur, on modifie radicalement sa pharmacocinétique et sa biodistribution. Le vecteur protège l’organisme de la toxicité du médicament pendant son transit et, inversement, protège le médicament d’une dégradation prématurée dans le sang. Le but est de concentrer l’action là où elle est nécessaire (la tumeur, le tissu enflammé) et de l’éviter partout ailleurs. Le nanovecteur n’est donc pas un simple contenant ; c’est un agent actif de la stratégie thérapeutique, conçu pour naviguer dans l’environnement biologique complexe et déjouer les défenses de l’organisme.

L’efficacité de cette approche est particulièrement frappante avec des médicaments dont la toxicité limitait l’usage. L’exemple du busulfan, un agent alkylant utilisé en hématologie, est emblématique. Sa faible solubilité et sa toxicité hépatique rendent son administration délicate. Une étude a démontré la capacité d’une cage nanométrique de type Metal-Organic Framework (MOF), le MIL-100, à résoudre ce problème. Cette structure a permis de stocker une quantité impressionnante de busulfan, représentant jusqu’à 25% de son poids total.

Étude de cas : Encapsulation record du busulfan

En utilisant des carboxylates de fer (MIL-100), des chercheurs ont réussi à encapsuler le busulfan avec une efficacité remarquable. Le nanovecteur a pu stocker 25% de son poids en médicament. À titre de comparaison, c’est cinq fois plus que les meilleurs polymères nanométriques et soixante fois plus que les liposomes classiques. Cette capacité d’encapsulation exceptionnelle réduit drastiquement les risques de recristallisation du médicament dans le système veineux hépatique, transformant de fait un composé hautement toxique en une thérapie potentiellement plus sûre et plus efficace.

Cet exemple illustre parfaitement la mission de la vectorisation : elle ne change pas la nature du principe actif, mais elle réécrit complètement les règles de son interaction avec le corps humain, transformant des poisons potentiels en remèdes de précision.

Pourquoi ces molécules en forme d’arbre sont-elles idéales pour transporter plusieurs médicaments à la fois ?

Les dendrimères sont des macromolécules synthétiques à l’architecture unique, parfaitement définie et hautement ramifiée, qui évoque celle d’un arbre. Partant d’un cœur central, des branches se développent de manière itérative, génération après génération, créant une structure tridimensionnelle sphérique. C’est cette architecture qui leur confère leurs propriétés exceptionnelles en tant que nanovecteurs. D’une part, l’intérieur de la molécule peut contenir des cavités capables d’encapsuler des principes actifs hydrophobes. D’autre part, la surface externe, constellée de nombreux groupes fonctionnels terminaux, peut être modifiée à l’envi. On peut y greffer des agents de ciblage (anticorps, peptides) pour diriger le dendrimère vers des cellules spécifiques, des agents d’imagerie, ou même un second type de médicament.

Cette capacité à porter simultanément plusieurs types de molécules fonctionnelles (ciblage, imagerie, thérapie) en fait des candidats de choix pour les approches de thérapies combinées et de théranostique. Leur structure monodispersée, où chaque molécule est quasi identique à sa voisine, assure une reproductibilité lot à lot qui est un atout majeur pour le développement pharmaceutique. On estime aujourd’hui que les dendrimères sont utilisés dans plus de 60% des pipelines de développement de nanomédicaments, témoignant de leur polyvalence.

Cependant, cette plateforme n’est pas exempte de compromis. L’arbitrage principal concerne la capacité de charge. Comme le souligne l’European Observatory for Nanomaterials, l’avantage de la stabilité a une contrepartie directe :

Les dendrimères sont mécaniquement plus stables que les liposomes, mais ils ne peuvent transporter que de petites quantités du médicament.

– European Observatory for Nanomaterials, Rapport sur l’avenir des nanomédicaments

Le choix d’un dendrimère est donc un calcul stratégique : il est privilégié lorsque la polyvalence (multi-fonctionnalisation) et la stabilité sont plus critiques que la quantité de principe actif à délivrer. Pour des thérapies nécessitant une dose élevée d’un seul médicament, d’autres vecteurs comme les liposomes peuvent s’avérer plus pertinents.

Comment mélanger des lipides et de l’ARN pour créer une sphère protectrice stable ?

Les liposomes sont des vésicules sphériques formées par une ou plusieurs bicouches de phospholipides, les mêmes molécules qui constituent les membranes de nos cellules. Cette composition intrinsèquement biocompatible est leur atout maître. Lorsqu’on mélange des lipides spécifiques en milieu aqueux, ils s’auto-assemblent spontanément pour former ces sphères, encapsulant au passage une partie du milieu environnant. Cet intérieur aqueux est idéal pour transporter des molécules hydrophiles, comme les acides nucléiques (ARN, ADN), tandis que la double couche lipidique peut solubiliser des médicaments hydrophobes. Cette polyvalence explique en grande partie pourquoi, selon les analyses de marché, le segment des liposomes domine avec 35.6% de part de marché de la nanomédecine en 2024.

La création d’une nanoparticule lipidique (LNP) stable pour délivrer de l’ARN, un exploit rendu célèbre par les vaccins contre la Covid-19, est un processus chimique précis. Il implique généralement un mélange rapide de deux solutions : une solution aqueuse acide contenant l’ARN (chargé négativement) et une solution alcoolique contenant un cocktail de lipides. Ce cocktail inclut typiquement des lipides cationiques (qui interagissent avec l’ARN), des phospholipides structurels, du cholestérol pour la stabilité et des lipides pégylés pour la furtivité. Le changement rapide de solvant et de pH provoque la précipitation et l’auto-assemblage des lipides autour de l’ARN, formant une sphère compacte et protectrice.

Étude de cas : Le succès des vaccins ARNm à nanoparticules lipidiques (LNP)

Les vaccins à ARNm contre la Covid-19 sont l’exemple le plus spectaculaire de l’efficacité de cette technologie. L’ARNm est une molécule extrêmement fragile, rapidement dégradée par les enzymes dans le corps. Les LNP forment une coque protectrice qui non seulement préserve l’intégrité de l’ARNm pendant son transit, mais facilite aussi son entrée dans les cellules cibles. En fusionnant avec la membrane cellulaire (qui est de même nature lipidique), la LNP libère directement l’ARNm dans le cytoplasme, où il peut être traduit en protéine pour déclencher la réponse immunitaire. Ce succès a validé la technologie LNP comme une plateforme de choix pour l’avenir des thérapies géniques et des vaccins.

L’arbitrage principal des liposomes réside dans leur stabilité mécanique et chimique, qui est inférieure à celle des dendrimères ou des nanoparticules inorganiques. Leur production à grande échelle nécessite des procédés contrôlés (comme l’extrusion ou la microfluidique) pour garantir une taille homogène, et leur conservation peut exiger des conditions strictes (comme la congélation) pour éviter la dégradation ou l’agrégation.

Comment un gel nanométrique peut-il gonfler et libérer son contenu en changeant de pH ?

Les nanogels sont des réseaux de polymères réticulés capables d’absorber de grandes quantités d’eau, formant une structure gélifiée à l’échelle nanométrique. Leur caractéristique la plus intéressante est leur capacité à être « intelligents » ou « stimulo-sensibles ». En choisissant des monomères spécifiques pour construire le réseau polymérique, on peut concevoir des nanogels qui changent radicalement de propriétés (typiquement, leur volume) en réponse à une variation de leur environnement. Les stimuli peuvent être variés : température, lumière, champ magnétique ou, de manière très pertinente en oncologie, le pH. Ce mécanisme permet une libération contrôlée et ciblée du médicament, uniquement lorsque le nanovecteur atteint la zone souhaitée.

Le ciblage par pH est particulièrement stratégique. En effet, l’environnement de nombreux tissus tumoraux est légèrement plus acide que celui des tissus sains. Les recherches montrent une différence significative, avec un pH de 7.4 pour les cellules saines contre un pH de 5.5 à 6.5 pour les tumeurs et jusqu’à 4.5 à l’intérieur des compartiments cellulaires comme les endosomes. Un nanogel peut être conçu pour rester compact et stable dans le sang (pH 7.4), retenant fermement le médicament. À son arrivée dans le microenvironnement tumoral acide, les groupes fonctionnels du polymère se protonent, augmentant les répulsions électrostatiques à l’intérieur du réseau. Le gel gonfle alors subitement, relâchant le principe actif précisément là où il est requis. C’est le principe de la libération « sur commande ».

Application en ophtalmologie des nanogels thermosensibles

Un exemple élégant de cette libération contrôlée, bien que basé sur la température, se trouve en ophtalmologie. Des nanogels thermosensibles ont été développés pour des traitements oculaires. À température ambiante, la formulation est liquide, ce qui permet une application facile sous forme de collyre. Une fois instillée dans l’œil, au contact de la surface oculaire à 37°C, la solution gélifie instantanément. Cette transition de phase forme un réservoir de médicament qui adhère à la cornée et permet une libération prolongée du principe actif. L’avantage pour le patient est considérable : la fréquence des applications journalières est drastiquement réduite, améliorant l’observance du traitement.

L’arbitrage pour les nanogels concerne leur complexité de synthèse et de caractérisation, ainsi que la spécificité du mécanisme de libération. La conception doit être parfaitement adaptée au stimulus visé, et le risque d’une libération prématurée ou d’une réponse non désirée à un autre facteur environnemental doit être soigneusement maîtrisé.

Billes d’or ou de latex : quel marqueur choisir pour un test de grossesse ultra-sensible ?

Si les nanovecteurs sont souvent associés à la thérapie, leur impact dans le domaine du diagnostic est tout aussi révolutionnaire. Les tests rapides, comme les tests de grossesse, reposent sur des immunodosages à flux latéral. Historiquement, ces tests utilisaient des microparticules de latex colorées comme marqueurs. Cependant, l’avènement des nanoparticules d’or a marqué un saut qualitatif en termes de sensibilité et de fiabilité. L’or colloïdal possède des propriétés optiques uniques, notamment un phénomène appelé résonance plasmon de surface, qui lui confère une couleur rouge rubis extrêmement intense et stable. Cette intensité chromatique permet de détecter des concentrations très faibles d’analyte (comme l’hormone hCG pour la grossesse), rendant les tests plus sensibles et plus précoces.

Au-delà du diagnostic in vitro, les nanoparticules inorganiques, notamment l’or et les oxydes de fer, sont au cœur du concept de théranostique. Ce terme désigne l’intégration au sein d’une seule et même nanoparticule d’un agent de diagnostic (pour visualiser) et d’un agent thérapeutique (pour traiter). Une nanoparticule d’oxyde de fer peut servir d’agent de contraste pour l’Imagerie par Résonance Magnétique (IRM), permettant de localiser précisément une tumeur. Une fois la cible identifiée, cette même particule, si elle est soumise à un champ magnétique alternatif, peut générer de la chaleur (hyperthermie) et détruire les cellules cancéreuses. Si on y greffe en plus un médicament, on obtient une triple action : voir, chauffer et traiter. Une étude de l’INSERM révèle d’ailleurs que l’utilisation de nanoparticules permet une augmentation de 25% de la précision des diagnostics par IRM.

Étude de cas : Les nanoparticules hybrides théranostiques du CEA

Des chercheurs du CEA ont illustré ce concept en développant des nanoparticules hybrides polyRFe3O4. Ces objets combinent plusieurs fonctionnalités au sein d’une seule plateforme : elles agissent comme agents de contraste performants pour l’IRM, permettant une visualisation précise des tissus. Simultanément, elles peuvent être activées pour un traitement par hyperthermie. Enfin, leur surface peut être fonctionnalisée pour transporter un principe actif thérapeutique de manière ciblée. C’est l’incarnation de la théranostique, où la frontière entre l’outil de diagnostic et le médicament s’estompe pour créer une approche de médecine personnalisée intégrée.

L’arbitrage stratégique pour les nanoparticules d’or et autres matériaux inorganiques est clair : il concerne leur toxicité potentielle et leur bio-persistance. Contrairement aux lipides ou à certains polymères, ces matériaux ne sont pas toujours facilement dégradés ou éliminés par l’organisme, ce qui soulève des questions sur leur accumulation à long terme.

Carbone biodégradable ou Silice persistante : quel risque accepter pour sauver un patient ?

La question de la toxicité et de la biocompatibilité est sans doute l’arbitrage le plus critique dans le développement d’un nanomédicament. Le choix du matériau de base du vecteur conditionne son devenir dans l’organisme. On peut distinguer deux grandes familles : les matériaux organiques (lipides, polymères, dendrimères), généralement conçus pour être biodégradables, et les matériaux inorganiques (or, silice, oxydes de fer, nanotubes de carbone, points quantiques), qui sont souvent bio-persistants. Un vecteur biodégradable sera décomposé par les processus métaboliques du corps en molécules plus petites, non toxiques et facilement éliminables. C’est un avantage sécuritaire majeur. Un vecteur bio-persistant, lui, n’est pas (ou très lentement) dégradé et peut s’accumuler dans certains organes comme le foie, la rate ou les reins, posant des risques de toxicité à long terme.

Le dilemme est que certains des matériaux les plus performants en termes de propriétés physiques (optiques, magnétiques) sont inorganiques. Les nanotubes de carbone, par exemple, ont des propriétés mécaniques et électriques exceptionnelles, mais leur structure en aiguille et leur persistance soulèvent de vives inquiétudes. Comme le note un rapport de l’Observatoire européen des nanomatériaux :

Pour les nanotubes de carbone et les points quantiques, la toxicité constitue un problème important, et les chercheurs examinent comment rendre ces matériaux moins toxiques avant de les utiliser pour des applications médicales.

– European Observatory for Nanomaterials, Rapport sur les nanomatériaux émergents

L’acceptation du risque dépend entièrement du contexte clinique. Pour une maladie chronique non mortelle, l’utilisation d’un vecteur bio-persistant est difficilement justifiable. En revanche, pour un cancer agressif au pronostic vital engagé, le bénéfice d’une thérapie efficace peut l’emporter sur le risque potentiel d’une accumulation à long terme. C’est un calcul bénéfice/risque qui doit être fait au cas par cas, en s’appuyant sur des données toxicologiques robustes. Le domaine est en pleine effervescence, avec, selon l’INSERM, plus de 400 essais cliniques utilisant des nanoparticules en cours dans le monde, chacun évaluant cet équilibre délicat.

La recherche s’oriente également vers des solutions hybrides, comme des nanoparticules de silice mésoporeuse conçues pour se désagréger lentement en acide silicique, une molécule biocompatible, ou des revêtements de surface qui favorisent l’élimination du vecteur. L’enjeu est de conserver les propriétés uniques des matériaux inorganiques tout en garantissant leur innocuité à long terme.

L’erreur de surface qui attire les protéines du sang et neutralise votre nanovecteur

Lorsqu’un nanovecteur est injecté dans la circulation sanguine, il est immédiatement confronté à un environnement hostile. Sa surface entre en contact avec des centaines de protéines plasmatiques différentes (albumine, immunoglobulines, etc.) qui peuvent s’y adsorber. Ce phénomène, appelé opsonisation, conduit à la formation d’une « couronne » de protéines autour de la nanoparticule. Cette couronne biologique modifie complètement l’identité du vecteur : elle masque ses agents de ciblage, change sa taille et sa charge de surface, et surtout, elle le signale comme un corps étranger au système immunitaire. Les cellules du système réticulo-endothélial, notamment les macrophages du foie (cellules de Kupffer) et de la rate, reconnaissent cette couronne et capturent massivement les nanovecteurs, les éliminant de la circulation en quelques minutes seulement. Le médicament n’a alors aucune chance d’atteindre sa cible.

Cette capture rapide est l’un des plus grands obstacles à l’efficacité des nanomédicaments. L’erreur de conception serait de se concentrer uniquement sur le cœur du vecteur et son contenu, en négligeant l’ingénierie de sa surface. Pour devenir « furtif » et échapper à cette surveillance immunitaire, le nanovecteur doit être rendu aussi « invisible » que possible.

La stratégie la plus répandue et la plus efficace pour contrer ce phénomène est la PEGylation. Elle consiste à greffer à la surface du nanovecteur des chaînes d’un polymère hydrophile, le polyéthylène glycol (PEG).

Étude de cas : La PEGylation, bouclier stérique des nanovecteurs

Les chaînes de PEG, très mobiles et fortement hydratées, créent une sorte de « brosse » polymérique autour de la nanoparticule. Cette couche hydrophile agit comme un bouclier par répulsion stérique : elle empêche physiquement les protéines plasmatiques de s’approcher et de s’adsorber à la surface du vecteur. En inhibant la formation de la couronne protéique, la PEGylation rend le nanovecteur « furtif ». Il n’est plus reconnu par les macrophages, ce qui évite sa capture massive par le foie et la rate. Le résultat est une prolongation spectaculaire de son temps de circulation dans le sang, qui peut passer de quelques minutes à plusieurs heures, voire plusieurs jours, augmentant ainsi considérablement ses chances d’atteindre sa cible thérapeutique par accumulation passive (effet EPR).

Toutefois, même la PEGylation a ses limites et fait l’objet d’arbitrages. Des études récentes montrent que l’organisme peut développer des anticorps anti-PEG, ce qui peut réduire l’efficacité du traitement lors d’injections répétées. La recherche explore donc activement des alternatives, comme des polymères « biomimétiques » qui imitent la surface de nos propres cellules pour passer inaperçus.

À retenir

- La vectorisation vise à élargir la fenêtre thérapeutique en augmentant l’efficacité au site cible et en réduisant la toxicité systémique.

- Chaque type de nanovecteur (dendrimère, liposome, particule inorganique) représente un compromis stratégique entre capacité de charge, biocompatibilité, stabilité et fonctionnalité.

- La scalabilité et la conformité aux normes de production GMP sont des critères de décision aussi importants que l’efficacité biologique pour la viabilité d’un projet.

Quand arrêter la synthèse artisanale pour passer aux réacteurs de nanovecteurs GMP ?

La transition du laboratoire à la production industrielle est un moment charnière, souvent appelé la « vallée de la mort » du développement pharmaceutique. Pour un nanomédicament, ce défi est décuplé. Une synthèse qui fonctionne parfaitement à l’échelle du milligramme dans un ballon en verre peut s’avérer impossible à reproduire de manière fiable et stérile dans un réacteur de plusieurs litres. Le passage à la production selon les Bonnes Pratiques de Fabrication (BPF, ou GMP en anglais) n’est pas une simple mise à l’échelle ; c’est un changement de paradigme qui doit être anticipé très tôt dans le processus de R&D. Attendre les phases cliniques avancées pour se poser la question de l’industrialisation est une erreur stratégique qui peut condamner un projet prometteur.

Le moment clé pour envisager cette transition se situe à la fin des études précliniques, lorsque les preuves d’efficacité et de non-toxicité chez l’animal sont établies. À ce stade, il faut non seulement produire des lots pour les premiers essais sur l’homme, mais aussi prouver aux agences réglementaires que le procédé de fabrication est robuste, contrôlé et reproductible. Cela implique de passer de réactifs de qualité « laboratoire » à des matières premières de grade pharmaceutique, de valider chaque étape du processus, et de mettre en place des contrôles qualité rigoureux pour caractériser chaque lot (taille, charge, pureté, etc.). Cet enjeu est d’autant plus crucial que les investissements globaux dans le secteur ont dépassé les 20 milliards de dollars sur les dernières années, et les investisseurs exigent des garanties sur la faisabilité industrielle.

Checklist d’évaluation pour la scalabilité GMP

- Synthèse et Pureté : Le procédé de synthèse est-il reproductible à grande échelle ? Quels sont les niveaux d’impuretés acceptables et comment sont-ils contrôlés ?

- Caractérisation du Lot : Les outils analytiques (DLS, TEM, HPLC, etc.) sont-ils en place pour garantir la cohérence de la taille, de la charge et de la composition de chaque lot produit ?

- Stabilité : Le nanovecteur est-il stable dans sa formulation finale dans des conditions de stockage et de transport réalistes ? Des études de vieillissement accéléré ont-elles été initiées ?

- Coût des Matières Premières : Le coût des précurseurs et des réactifs de grade GMP est-il compatible avec un modèle économique viable (Cost of Goods) pour le produit final ?

- Dossier Réglementaire (CMC) : Les données sur la Chimie, la Fabrication et le Contrôle (Chemistry, Manufacturing, and Controls) sont-elles suffisantes pour constituer un dossier solide pour les agences réglementaires ?

Cette transition représente un investissement financier et humain considérable qui nécessite des infrastructures et des compétences spécifiques. Comme le souligne le Dr Nathalie Mignet, présidente de la Société française de nanomédecine, la structuration de la filière est un enjeu national :

La France doit se structurer dans ce domaine, disposer d’un laboratoire dédié, semblable au NCL américain, avec des laboratoires reconnus pour valider les nanotechnologies.

– Dr Nathalie Mignet, Présidente de la Société française de nanomédecine

L’analyse rigoureuse de ces paramètres, de la conception moléculaire à la stratégie industrielle, constitue l’étape indispensable pour transformer une innovation de laboratoire en une solution thérapeutique viable et finançable.