Le passage à l’échelle nanométrique n’est pas un simple défi technique, mais un pivot stratégique qui impose de réinventer les processus mêmes de l’innovation.

- Les lois de la physique changent radicalement sous 100 nm, rendant les approches R&D classiques obsolètes.

- Le principal frein n’est pas le coût de la recherche, mais le manque de fonds propres pour l’industrialisation et une mauvaise appréciation des indicateurs de maturité.

Recommandation : Auditez vos processus R&D non pas sur leur capacité technique, mais sur leur agilité à piloter des projets où la physique fondamentale du produit est encore une inconnue.

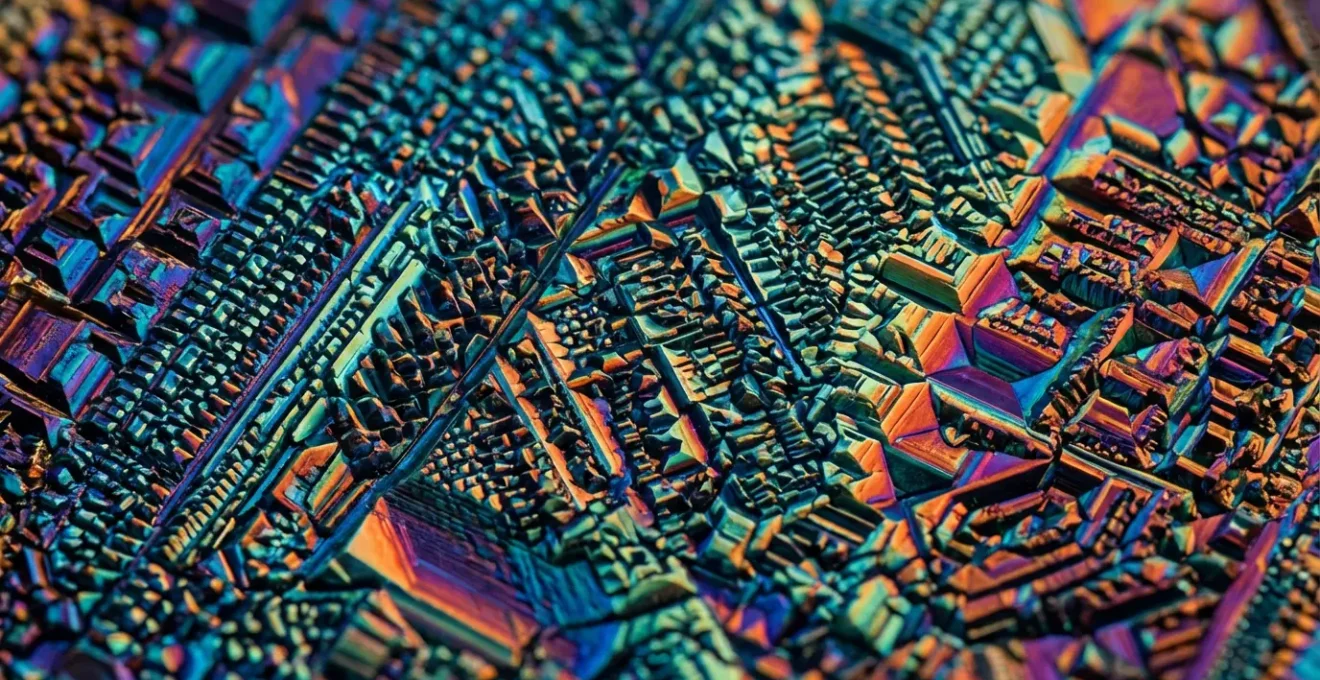

L’obsession de la miniaturisation a longtemps dicté le rythme de l’innovation industrielle. Pousser les limites, rendre les composants plus petits, plus rapides, plus efficaces. Mais que se passe-t-il lorsque cette course effrénée nous amène à une frontière où les règles du jeu changent complètement ? Nous y sommes. L’ingénierie des nanosciences n’est pas une simple continuation de la miniaturisation ; c’est une rupture fondamentale. Pour les directeurs R&D et les responsables de l’innovation, ignorer ce changement de paradigme n’est plus une option. C’est risquer l’obsolescence stratégique.

On évoque souvent les applications visibles des nanotechnologies, des crèmes solaires aux puces électroniques. Mais ces exemples masquent l’essentiel du défi pour les industriels. Le véritable enjeu n’est pas de comprendre la physique quantique dans ses moindres détails, mais de savoir comment transformer son organisation pour exploiter un potentiel où la matière elle-même devient programmable. La question n’est plus seulement « que pouvons-nous fabriquer ? », mais « comment devons-nous repenser nos processus de conception, nos modèles d’investissement et notre gestion du risque pour innover dans un monde aux lois physiques contre-intuitives ? ».

Cet article adopte une perspective de consultant en stratégie technologique. Notre objectif n’est pas de vous donner un cours de physique, mais de vous fournir une feuille de route pour la prise de décision. Nous allons déconstruire l’idée que l’intégration des nanosciences est avant tout une question de budget ou de savoir-faire technique. Nous verrons qu’il s’agit d’un pivot stratégique qui exige de nouveaux indicateurs, une nouvelle culture de l’incertitude et une nouvelle approche de l’écosystème d’innovation. Il s’agit de passer d’une R&D qui améliore à une R&D qui réinvente.

Pour naviguer dans cette révolution, nous explorerons les implications stratégiques de l’échelle nanométrique, depuis la remise en cause des lois physiques jusqu’aux méthodes pour piloter un projet dans l’incertitude. Cet article est structuré pour vous guider pas à pas dans cette nouvelle dimension de la R&D.

Sommaire : Les implications stratégiques des nanosciences pour la R&D du futur

- Pourquoi les lois de la physique classique ne s’appliquent plus sous 100 nanomètres ?

- Comment adapter vos processus de R&D pour intégrer l’échelle nanométrique sans exploser le budget ?

- Ingénierie classique ou nanosciences : quelle approche pour les matériaux de demain ?

- L’erreur de conception qui retarde 60% des projets de nanotechnologie

- Quand investir dans un département nanosciences : les 3 indicateurs de maturité

- Comment passer du labo à l’usine pilote en moins de 18 mois pour une application nano ?

- Comment piloter un projet quand la physique du produit n’est pas encore totalement comprise ?

- Comment les matériaux nanostructurés surpassent-ils les alliages traditionnels en résistance pure ?

Pourquoi les lois de la physique classique ne s’appliquent plus sous 100 nanomètres ?

En tant que décideur, la première rupture à intégrer n’est pas technologique, mais conceptuelle. Sous la barre symbolique des 100 nanomètres, l’intuition forgée par le monde macroscopique devient un piège. La gravité, force dominante à notre échelle, devient négligeable. À l’inverse, des forces considérées comme faibles, telles que les forces de Van der Waals, deviennent prépondérantes. Ce n’est pas une simple nuance ; c’est un renversement complet des hiérarchies. La physique nous apprend que la force d’interaction de Van der Waals entre deux atomes décroît selon une loi en 1/R⁷, bien plus rapidement que les forces gravitationnelles ou électrostatiques en 1/R². Cela signifie que les interactions à très courte portée dictent le comportement de la matière.

Ce changement a une conséquence stratégique majeure : la surface d’un objet devient plus importante que son volume. Les propriétés d’un nanomatériau (sa réactivité chimique, sa conductivité, ses propriétés optiques) sont directement dictées par les atomes situés à sa surface. Modifier quelques atomes en surface peut transformer radicalement le matériau. Comme le résume la plateforme StudySmarter Engineering, ce principe est central :

À l’échelle nanométrique, les forces de Van der Waals deviennent prédominantes sur d’autres types de forces en raison de la surface proportionnellement plus grande par rapport au volume.

– StudySmarter Engineering, Forces de Van der Waals en ingénierie nanométrique

Pour une direction R&D, cela signifie que la conception de nouveaux matériaux ne consiste plus à mélanger des substances (chimie classique), mais à architecturer la matière atome par atome. C’est passer du rôle de « cuisinier » à celui d’architecte moléculaire. Cette transition exige de nouvelles compétences, de nouveaux outils de simulation et, surtout, une nouvelle façon de penser l’expérimentation.

Comment adapter vos processus de R&D pour intégrer l’échelle nanométrique sans exploser le budget ?

La perception commune associe les nanotechnologies à des investissements colossaux en équipements de pointe, inaccessibles pour beaucoup d’entreprises. Si l’acquisition d’un microscope à effet tunnel ou d’une salle blanche représente un coût certain, l’erreur stratégique est de penser en termes de possession plutôt que d’accès. La clé pour intégrer l’échelle nanométrique de manière agile et financièrement soutenable réside dans l’écosystème d’innovation mutualisé. Des structures comme le réseau RENATECH+ en France fédèrent des centrales technologiques de pointe, offrant un accès à des équipements et des expertises de classe mondiale sans l’investissement initial massif.

L’adaptation des processus R&D passe donc moins par la construction d’infrastructures que par la capacité à s’intégrer dans ces réseaux. Cela implique de développer des compétences en gestion de projets collaboratifs, en partage de propriété intellectuelle et en pilotage à distance. L’enjeu n’est plus d’avoir le meilleur laboratoire, mais d’être le meilleur pour utiliser les laboratoires des autres. L’approche consiste à tester des concepts sur des plateformes mutualisées avant d’envisager tout investissement interne majeur, réduisant ainsi drastiquement le risque financier.

Votre plan d’action pour une nano-R&D optimisée

- Mutualisation : Identifiez et utilisez les plateformes mutualisées comme RENATECH+ (qui fédère 5 centrales nationales et 28 centrales régionales en France) pour accéder aux équipements de pointe sans investissement massif.

- Priorisation : Concentrez vos efforts sur les technologies critiques où l’impact sera maximal pour votre secteur. Des organismes comme NANOFUTUR identifient des axes porteurs : photonique, spintronique, nanobiotechnologies, etc.

- Collaboration : Structurez vos investissements sous forme de consortiums avec des accords clairs de partage des coûts et de la propriété intellectuelle pour démultiplier votre force de frappe.

Adopter ce modèle transforme la R&D d’un centre de coût fixe à un investissement variable et flexible, directement corrélé au potentiel des projets explorés. C’est une révolution dans la manière de concevoir le budget innovation.

Ingénierie classique ou nanosciences : quelle approche pour les matériaux de demain ?

L’une des erreurs d’analyse les plus courantes est d’opposer l’ingénierie des matériaux classique à l’approche par les nanosciences. Cette vision binaire est un frein à l’innovation. Les entreprises les plus performantes ne choisissent pas l’une contre l’autre ; elles les combinent dans une approche d’ingénierie multi-échelle. Il s’agit de concevoir un produit en optimisant simultanément ses propriétés macroscopiques (résistance mécanique, flexibilité) et ses fonctionnalités nanoscopiques (propriétés catalytiques, capteurs intégrés, auto-réparation).

Le matériau de demain n’est pas « nano » ou « classique », il est « hiérarchique ». Sa performance globale dépend de l’agencement intelligent de structures à différentes échelles, de l’atome au produit fini. Pensez à une structure osseuse : sa légèreté et sa résistance proviennent d’une organisation complexe allant des nanocristaux d’hydroxyapatite jusqu’à la structure macroscopique de l’os. L’objectif de la R&D moderne est d’imiter et de surpasser cette complexité naturelle.

Étude de cas : L’approche multi-échelle du CEA en nanomédecine

Depuis 2012, le CEA développe le centre Nano-INNOV en région parisienne, qui regroupe plusieurs plateformes technologiques mutualisées, dont NanoMED. Cette initiative illustre parfaitement la complémentarité des approches. Les chercheurs y développent des dispositifs médicaux innovants, comme des capteurs ou des systèmes d’administration de médicaments, en combinant l’ingénierie de précision classique pour le dispositif global avec les nanosciences pour la fonctionnalisation de sa surface active. Le succès du projet ne repose pas sur la suprématie d’une discipline, mais sur leur dialogue constant.

Pour un directeur R&D, la conclusion est claire : il ne faut pas remplacer ses ingénieurs matériaux par des physiciens quantiques, mais créer des équipes pluridisciplinaires où ces deux cultures dialoguent. La véritable rupture naîtra de la capacité à traduire un besoin macroscopique (ex: un revêtement plus durable) en une solution nanométrique (ex: une surface nanostructurée qui limite l’usure).

L’erreur de conception qui retarde 60% des projets de nanotechnologie

Lorsqu’un projet de nanotechnologie prometteur échoue à atteindre le marché, l’intuition pointe souvent vers un obstacle technique insurmontable ou un manque de financement pour la R&D. C’est une analyse incomplète qui peut coûter cher. Une erreur de conception stratégique fondamentale, commise très en amont, est souvent la véritable cause. Cette erreur consiste à se focaliser exclusivement sur la faisabilité technique (le « Proof of Concept ») en négligeant la planification de l’industrialisation et l’écosystème réglementaire.

Un rapport du ministère de l’Économie français met en lumière une réalité contre-intuitive : le principal obstacle n’est pas tant le soutien à la R&D, souvent bien financée, mais le manque de fonds propres qui freine le déploiement industriel. Autrement dit, les entreprises réussissent à inventer en laboratoire mais échouent à financer le passage à l’échelle, l’étape la plus capitalistique. Cette « vallée de la mort » de l’innovation est particulièrement profonde pour les nanotechnologies en raison des coûts d’équipement des premières lignes de production.

À ce frein financier s’ajoute une complexité réglementaire et sociétale souvent sous-estimée, comme le souligne le même rapport :

L’incompréhension envers la ‘déclaration Nano’ spécifique à notre pays et les résultats du débat public de 2009 qui semblent avoir priorisé les risques sur les avantages.

– Rapport CGE, Ministère de l’Économie – Déploiement industriel des nanotechnologies

L’erreur de conception est donc de piloter un projet nano comme un projet R&D classique. Un projet nano réussi doit intégrer dès le premier jour une feuille de route financière pour l’industrialisation, une stratégie de communication pour l’acceptabilité publique et une veille réglementaire active. Attendre la fin de la phase R&D pour se poser ces questions est la recette la plus sûre pour l’échec.

Quand investir dans un département nanosciences : les 3 indicateurs de maturité

La décision de créer ou de renforcer un département dédié aux nanosciences ne doit pas relever de l’effet de mode, mais d’une analyse stratégique froide. C’est un pivot organisationnel qui doit être justifié par des signaux clairs de maturité, tant internes qu’externes. Se lancer trop tôt, c’est risquer de brûler du capital sur des recherches trop fondamentales ; se lancer trop tard, c’est laisser un avantage concurrentiel décisif à ses rivaux. L’analyse des données sur les entreprises déjà actives dans le domaine permet de dégager trois indicateurs clés.

Ces indicateurs ne sont pas des règles absolues, mais des balises pour éclairer une décision stratégique complexe. Ils permettent de passer d’une intuition (« les nanos sont l’avenir ») à un diagnostic (« nous avons atteint la taille critique, notre secteur bascule et notre budget R&D peut absorber ce pivot »).

- Indicateur 1 : La taille critique de l’entreprise. Les données montrent que près de 50% des entreprises actives en R&D sur les nouveaux matériaux et nanotechnologies comptent plus de 50 salariés. En dessous de ce seuil, il est souvent plus judicieux de s’appuyer sur des partenariats et des plateformes externes.

- Indicateur 2 : Le positionnement sectoriel. L’investissement n’a de sens que si votre secteur est à un point de bascule. Actuellement, les investissements sont massivement concentrés dans les composants électroniques (63%) et, dans une moindre mesure, l’industrie chimique (4%). Si vous êtes dans ces domaines, l’attentisme est risqué.

- Indicateur 3 : La structure du budget R&D. Un signal fort de maturité est lorsque la Dépense Intérieure de R&D des Entreprises (DIRDE) représente déjà plus de 20% de votre budget R&D global. Cela indique que l’entreprise a déjà une culture de recherche internalisée et la capacité d’absorber des projets à plus haut risque et à plus long terme.

L’évaluation honnête de ces trois points fournit une base solide pour justifier (ou reporter) un investissement majeur dans une structure interne dédiée aux nanosciences.

Comment passer du labo à l’usine pilote en moins de 18 mois pour une application nano ?

Accélérer le passage du laboratoire à l’usine pilote — le fameux « scale-up » — est le Saint Graal de l’innovation de rupture. Pour une application nanotechnologique, ce défi est décuplé. Les processus qui fonctionnent sur un échantillon de quelques millimètres carrés échouent souvent lamentablement lorsqu’il s’agit de produire en série. La clé du succès en moins de 18 mois ne réside pas dans la vitesse brute, mais dans l’anticipation des contraintes industrielles dès la phase de recherche fondamentale.

L’enjeu financier est colossal. Les investissements dans le domaine en France témoignent de cette priorité stratégique. Selon les statistiques du ministère de la Recherche, l’effort total représentait près de 3,5 milliards d’euros investis en 2018, soit 10% de la DIRDE totale, une part significative dédiée en grande partie à lever ces verrous de l’industrialisation.

Étude de cas : Le défi de l’industrialisation des résines bio-sourcées au CNRS

Des chercheurs du CNRS développent une résine pour la nanolithographie à base de chitosane, un dérivé de carapaces de crustacés, afin de remplacer les résines pétrochimiques. Le succès en laboratoire est avéré. Cependant, le principal défi pour le passage à l’échelle industrielle n’est pas la synthèse du produit, mais l’adaptation du processus aux cadences de production. Le temps d’insolation (exposition à la lumière pour graver les motifs) doit être drastiquement réduit pour être compatible avec les spécifications des lignes de production existantes, tout en conservant une résolution de gravure nanométrique. Cet exemple montre que la variable « temps de cycle » est aussi critique que la performance pure du matériau.

Pour réussir ce passage en un temps record, la méthodologie R&D doit intégrer un « jumeau numérique » du processus industriel. Les chercheurs ne doivent pas seulement se demander « est-ce que mon matériau fonctionne ? », mais « est-ce que je peux le fabriquer 1000 fois par heure, avec une tolérance de 1%, en utilisant des équipements existants ? ». Simuler les contraintes de production (température, pression, vitesse) dès la paillasse est la seule manière de concevoir une innovation qui soit « industrialisable par conception ».

Comment piloter un projet quand la physique du produit n’est pas encore totalement comprise ?

C’est peut-être la question la plus déstabilisante pour un directeur R&D habitué à des processus structurés et prédictibles. Dans le monde des nanosciences, on lance parfois des projets dont les mécanismes physiques fondamentaux ne seront entièrement élucidés que bien plus tard. C’est le pilotage en environnement d’incertitude fondamentale. Attendre de tout savoir, c’est laisser la concurrence prendre une avance irrattrapable. Il faut donc agir malgré l’inconnu. Cette situation est parfaitement résumée par Yann Chevolot, chercheur au CNRS, à propos des résines bio-sourcées :

Nous ne parvenons pas encore à graver le chitosane avec des motifs aussi précis que sur les résines chimiques actuellement utilisées dans les nanotechnologies.

– Yann Chevolot, CNRS – Atténuer l’empreinte écologique des nanotechnologies

Cette phrase est révélatrice : l’objectif est clair, mais le « comment » physique précis est encore en cours de découverte. Comment piloter dans ce brouillard ? La réponse est un triptyque stratégique : simulation massive, approche itérative et diversification des pistes. Avant de lancer des expériences coûteuses en laboratoire, des milliers de scénarios sont testés via des modèles de simulation numérique pour prédire le comportement de la matière. Ces simulations ne donnent pas la certitude, mais elles permettent d’élaguer les impasses et d’identifier les voies les plus prometteuses.

L’approche devient alors probabiliste. On ne suit plus un plan linéaire, mais on gère un portefeuille d’hypothèses. Certaines stratégies de pilotage en environnement incertain incluent :

- Utiliser la simulation de dynamique moléculaire (MD) pour prédire le comportement vibratoire et mécanique de structures multi-couches avant de les synthétiser.

- Intégrer systématiquement les effets des forces de Van der Waals dans les modèles, surtout pour des matériaux 2D comme le graphène ou le phosphore noir (BP), qui sont très sensibles à ces interactions.

- Adopter une approche itérative rapide : les simulations montrent que les fréquences de résonance (un indicateur de stabilité et de performance) varient très différemment selon les matériaux (forte augmentation pour le phosphore noir, faible pour le graphène). Ces informations permettent d’ajuster la recherche en quasi-temps réel.

Piloter dans l’incertitude, c’est donc remplacer la planification rigide par une navigation agile, guidée par la simulation et l’expérimentation ciblée. C’est une compétence managériale autant que scientifique.

À retenir

- Le passage à l’échelle nanométrique impose un changement de paradigme : les lois physiques changent, et les processus R&D doivent suivre ce pivot.

- Le principal frein à l’innovation nano n’est pas le financement de la recherche, mais l’anticipation de l’industrialisation et l’évaluation des bons indicateurs de maturité.

- La clé du succès réside dans le pilotage de l’incertitude fondamentale, en utilisant la simulation et des approches itératives plutôt qu’une planification rigide.

Comment les matériaux nanostructurés surpassent-ils les alliages traditionnels en résistance pure ?

La supériorité des matériaux nanostructurés sur les alliages traditionnels n’est pas une question de « meilleur ingrédient », mais de « meilleure architecture ». Un alliage classique est comme un mur de briques posées de manière relativement homogène. Un nanomatériau est comme une structure en fibre de carbone, où la résistance naît de l’orientation et de l’interaction parfaite de chaque fibre à plusieurs échelles. La performance ne vient plus de la composition brute, mais de l’organisation hiérarchique de la matière.

Cette supériorité s’explique par la capacité à contrôler et à éliminer les défauts à l’échelle nanométrique. Dans un métal traditionnel, la rupture commence presque toujours au niveau d’un défaut microscopique (une dislocation, une impureté). En structurant le matériau atome par atome, on peut créer des structures quasi parfaites, ou mieux encore, des structures où les défauts sont intentionnellement répartis pour stopper la propagation des fissures. C’est ce qui permet à des matériaux comme le graphène d’être théoriquement 200 fois plus résistant que l’acier pour une fraction de son poids.

Cet avantage stratégique explique l’ampleur de l’effort national et international en R&D. En France, l’investissement dans la recherche et le développement représentait 2,24% du PIB en 2022, un chiffre où les nouveaux matériaux et les nanotechnologies occupent une place croissante. Surpasser les alliages traditionnels n’est donc plus une hypothèse de laboratoire, mais un objectif stratégique industriel qui mobilise des ressources considérables. Le véritable avantage concurrentiel ne viendra pas de la découverte d’un matériau miracle, mais de la maîtrise des processus permettant de concevoir et de produire ces architectures complexes à grande échelle et à un coût compétitif.

En synthèse, la redéfinition des standards de la R&D par les nanosciences est totale. Elle force les entreprises à passer d’une logique d’amélioration continue à une logique d’innovation de rupture, en changeant non seulement leurs produits, mais aussi et surtout leur manière de penser, d’organiser et de financer l’innovation.

L’étape suivante consiste à évaluer la maturité de votre propre organisation face à ce pivot stratégique. Commencez dès aujourd’hui à auditer vos processus R&D à la lumière de ces nouveaux paradigmes pour ne pas laisser passer la prochaine vague d’innovation industrielle.